历史回顾、当前技术热点、核心发展趋势、主要应用领域,以及面临的挑战与未来展望。

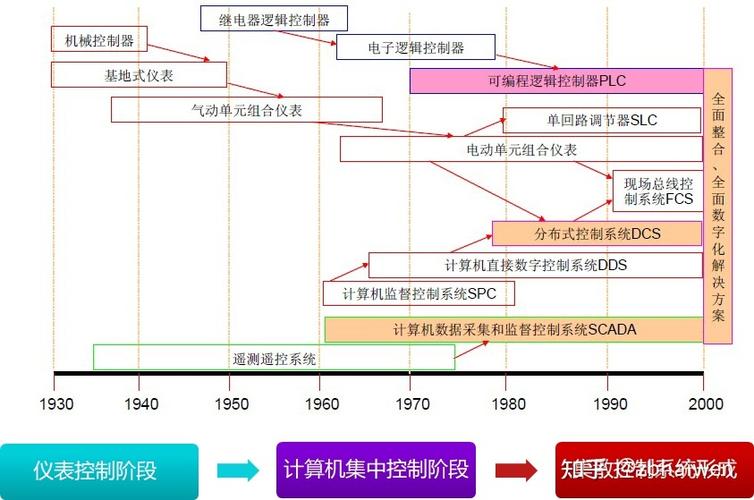

历史回顾:从通用处理器到专用架构

DSP技术的发展史,就是一部追求更高速度、更低功耗和更强实时处理能力的历史。

-

早期与奠基 (1970s-1980s):

- 概念诞生:数字信号处理的理论基础在1960-70年代就已奠定,如快速傅里叶变换算法。

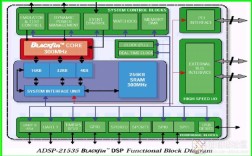

- 专用DSP芯片出现:1979年,美国AMI公司发布了世界上第一款商用单片DSP芯片 S2811,1983年,德州仪器推出了经典的TMS32010,这被认为是现代DSP的开端,这些早期芯片主要针对语音处理、调制解调等特定任务,采用哈佛架构(分离的程序总线和数据总线),极大地提升了运算效率。

-

快速发展与普及 (1990s-2000s):

- 性能飞跃:TI、ADI、Motorola(现为NXP)等厂商竞争激烈,DSP的性能(主频、运算能力)每18-24个月翻一番。

- 指令集优化:发明了单指令多数据架构,一条指令可以同时处理多个数据,非常适合向量/矩阵运算,是DSP性能提升的关键。

- 应用扩展:从通信基站、雷达系统,扩展到数字音视频、硬盘驱动器、汽车电子等消费和工业领域。

-

SoC融合与挑战 (2010s至今):

(图片来源网络,侵删)

(图片来源网络,侵删)- “摩尔定律”放缓:传统通过提升主频和晶体管数量来增加性能的方式遇到瓶颈,功耗和散热问题日益突出。

- 架构挑战:通用CPU(尤其是多核CPU)和GPU的性能急剧提升,开始侵占传统DSP的应用领域。

- SoC成为主流:为了应对挑战,DSP技术不再以独立芯片的形式存在,而是作为IP核被集成到SoC(System-on-a-Chip)中,与CPU、GPU、AI加速器等异构计算单元协同工作。

当前技术热点与核心发展趋势

当前,DSP技术的发展呈现出以下几个核心趋势:

异构计算与集成化

这是最显著的趋势,现代系统不再依赖单一的“最强”处理器,而是根据任务特点,将不同类型的处理器核集成在一起。

- SoC中的DSP核:在高端手机(如高通骁龙、苹果A系列)、自动驾驶芯片(如NVIDIA Orin)、基站SoC中,都集成了高性能的DSP核(如CEVA、Tensilica的DSP IP,或TI/ADI自家的核)。

- 协同工作:CPU负责通用操作系统和复杂逻辑调度,GPU负责图形渲染,DSP则负责对实时性、功耗比要求极高的信号处理任务(如基带调制解调、语音降噪、雷达信号处理),AI加速器(NPU)则负责深度学习推理,各司其职,实现系统性能最优。

AI与DSP的深度融合

AI,特别是深度学习,正在重塑信号处理的方式。

- AI赋能传统DSP算法:用AI模型替代传统的、基于数学公式的信号处理算法,用深度神经网络进行语音降噪,效果远超传统自适应滤波算法;用AI进行图像超分辨率重建,效果更自然。

- DSP为AI提供高效算力:DSP的并行计算能力非常适合执行神经网络中的大量乘加运算,一些新的DSP架构被专门优化以支持AI推理,如支持低精度(INT8/INT4)运算的指令集和硬件单元,这比使用FP32的GPU能效比更高。

- 端侧AI:在手机、智能家居设备、可穿戴设备等终端上运行AI模型,需要极高的能效比,集成了AI加速功能的DSP是实现这一目标的关键。

软件定义与可重构性

硬件平台越来越灵活,以适应快速变化的通信协议和应用需求。

- 软件定义无线电:这是最典型的例子,通过在通用可编程DSP或FPGA上实现基带处理,同一个硬件平台可以通过软件升级来支持不同的通信标准(如4G/5G/Wi-Fi 6/7),极大地降低了设备的成本和开发周期。

- 可配置DSP:一些新的DSP架构允许在运行时动态调整硬件配置,以适应不同的算法需求,提供了比固定功能硬件更大的灵活性。

极致能效的追求

在移动设备和物联网时代,功耗是决定产品成败的关键。

- 多核低功耗设计:采用“大小核”或“异构多核”架构,将高性能核心与低功耗核心结合,根据任务负载动态调度。

- 先进的制程工艺:采用7nm、5nm甚至更先进的半导体工艺,在提升性能的同时,大幅降低功耗。

- 专用指令集:为特定算法(如Viterbi、FFT)设计专用的硬件指令,用极低的功耗完成特定任务。

信号处理算法的革新

算法层面也在不断演进。

- 稀疏信号处理:利用信号在特定域(如小波域、压缩感知)中的稀疏性,用更少的采样和处理量来恢复原始信号,适用于5G Massive MIMO、医疗成像等领域。

- 边缘计算下的算法优化:为适应边缘设备的算力和功耗限制,研究更轻量、更高效的模型和算法,如模型剪枝、量化等。

主要应用领域

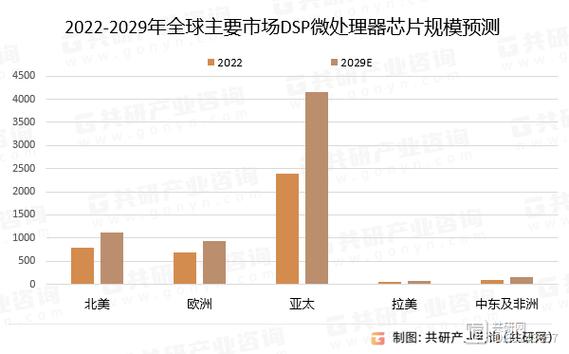

DSP技术已经渗透到现代科技的方方面面:

-

5G/6G通信:

- 基站:大规模MIMO波束赋形、信道编解码、基带处理等,对DSP的计算能力和实时性要求极高。

- 终端设备:手机中的基带芯片、Wi-Fi/蓝牙芯片,都离不开DSP进行复杂的信号调制解调。

-

人工智能与机器学习:

- 语音处理:语音识别、语音合成、实时语音翻译、智能降噪(如AirPods的通透模式)。

- 计算机视觉:图像/视频的预处理(去噪、增强)、目标检测、图像分割。

- 端侧AI:在手机、汽车、摄像头等设备上运行AI模型,DSP是核心执行单元之一。

-

汽车电子:

- 高级驾驶辅助系统:毫米波雷达信号处理、激光雷达点云数据处理、摄像头视觉信息处理。

- 车载信息娱乐系统:音效处理(如杜比全景声)、车载通信(V2X)。

- 电池管理系统:对电池充放电电流、电压进行高精度采样和处理。

-

音视频与消费电子:

- 音频:降噪、回声消除、空间音频、均衡器。

- 视频:视频编码(H.264/HEVC/AV1)、解码、画质增强(如HDR、插帧)。

- 可穿戴设备:智能手表/手环中的心率、血氧、ECG等生理信号的采集与处理。

-

工业与医疗:

- 工业自动化:电机控制、振动分析、故障诊断。

- 医疗成像:MRI、CT、超声设备的图像重建算法,对信号处理的精度和速度要求极为苛刻。

面临的挑战与未来展望

挑战:

- 来自CPU/GPU的竞争:虽然DSP在特定任务上有优势,但通用处理器和GPU的生态更成熟,编程更简单,且性能也在不断提升,挤压了传统DSP的生存空间。

- 开发复杂性:在异构SoC上进行软件开发,需要同时掌握CPU、DSP、AI加速器等多种架构的编程模型(如C/C++、OpenCL、特定厂商的SDK),开发门槛高。

- 安全性与可靠性:在自动驾驶、医疗等关键领域,对芯片的安全性和可靠性提出了前所未有的要求,防止软硬件故障和恶意攻击。

- 更智能的融合:未来的“处理器”将不再是单一的CPU或DSP,而是高度集成的、智能调度的“计算加速簇”,AI将不仅是处理对象,更会成为调度和管理所有计算资源的“大脑”。

- 存算一体:传统的“冯·诺依曼架构”中,计算单元需要频繁地从内存中取数据,数据搬运成为瓶颈。存算一体技术试图在存储单元内部直接进行计算,以突破这一瓶颈,极大提升AI和信号处理的能效比,这是未来芯片架构的重要方向。

- 面向特定领域的极致优化:随着RISC-V等开源指令集架构的兴起,针对特定应用(如6G通信、量子计算控制)定制化、可扩展的DSP将变得更加普遍。

- 边缘AI的普及:随着DSP和AI技术的结合,未来将有更多智能应用在终端设备上实时运行,实现真正的“万物智联”。

DSP技术的发展已经从一个追求独立、高性能芯片的时代,进入了一个深度融合、协同进化的新阶段,它不再是孤立的“数字信号处理器”,而是作为异构计算系统的核心引擎之一,与AI、CPU、GPU紧密协作,共同驱动着5G通信、人工智能、自动驾驶等前沿科技的进步,未来的DSP将更加智能、能效更高,并且深度融入我们生活的每一个角落。