语音识别技术原理简介

语音识别技术作为人工智能领域的重要分支,旨在将人类语音信号转换为计算机可读的文本或指令,其核心目标是实现人机交互的自然化与高效化,该技术的原理涉及信号处理、模式识别、机器学习等多个学科的交叉融合,通过一系列复杂的技术流程,将连续的语音信号离散化为具有语义的文本信息,从技术发展历程来看,语音识别已从早期的基于模板匹配的方法,逐步演变为以深度学习为主导的端到端模型,识别准确率和适用场景均得到显著提升。

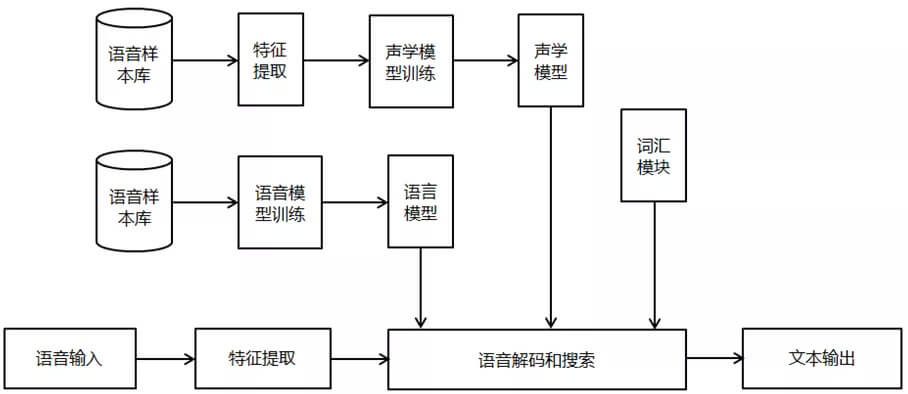

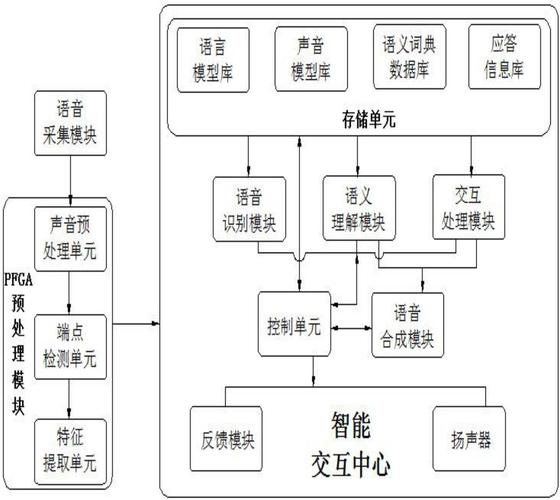

语音识别的基本流程可划分为前端处理、特征提取、声学模型、语言模型和解码输出五个核心环节,前端处理主要解决语音信号的预处理问题,包括语音端点检测和降噪技术,语音端点检测用于区分有效语音段与背景噪声,通过计算短时能量、过零率等参数,判断语音信号的起止位置,从而减少无效数据对后续识别的干扰,降噪技术则采用谱减法、维纳滤波等方法,抑制环境噪声对语音信号的干扰,提高信号的信噪比,在嘈杂的公共场所,降噪算法能够有效分离出目标说话人的语音,为后续特征提取提供 cleaner 的输入数据。

特征提取是连接语音信号与模型识别的关键桥梁,其目的是从原始语音信号中提取能够反映语音本质特性的特征参数,传统的特征提取方法以梅尔频率倒谱系数(MFCC)为代表,该技术首先对语音信号进行预加重、分帧和加窗处理,然后通过快速傅里叶变换(FFT)将时域信号转换为频域信号,再利用梅尔滤波器组对频谱进行滤波,最后通过对数运算和离散余弦变换(DCT)得到MFCC特征,MFCC特征能够较好地模拟人耳的听觉特性,在传统语音识别系统中占据主导地位,随着深度学习的发展,滤波器组特征(FBank)等更原始的频谱特征逐渐受到重视,这些特征保留了更多的频谱信息,能够更好地被深度神经网络模型利用。

声学模型是语音识别系统的核心组件,用于计算语音特征与音素、音节等基本语音单元之间的概率关系,在传统方法中,隐马尔可夫模型(HMM)与高斯混合模型(GMM)的组合(GMM-HMM)是主流技术,该模型将语音信号视为一个马尔可夫过程,通过状态转移概率和观测概率来描述语音的产生过程,GMM-HMM模型在处理高维特征和复杂语音现象时存在局限性,近年来,深度神经网络(DNN)与HMM结合的混合模型(DNN-HMM)成为过渡方案,DNN替代GMM承担概率密度估计任务,大幅提升了识别准确率,2010年后,端到端的深度学习模型逐渐兴起,如连接主义时间分类(CTC)、听写器模型(LAS)以及基于Transformer的语音识别模型,这些模型直接从语音特征映射到文本序列,简化了传统流程,并能够更好地捕捉语音序列的长期依赖关系。

语言模型用于评估文本序列的语法和语义合理性,其核心任务是计算给定文本序列的出现概率,在语音识别中,语言模型能够有效弥补声学模型在歧义消除方面的不足,例如通过上下文信息区分“买”和“卖”等发音相近但语义不同的词汇,传统的语言模型以N-gram模型为代表,该模型基于马尔可夫假设,通过统计文本中相邻N个词的共现频率来计算概率,N-gram模型存在数据稀疏性和长距离依赖捕捉能力不足的问题,为此,神经网络语言模型(NNLM)应运而生,通过词嵌入技术将词语映射为低维稠密向量,利用循环神经网络(RNN)、长短期记忆网络(LSTM)或Transformer等结构建模词语间的上下文关系,近年来,预训练语言模型(如BERT、GPT)在大规模文本数据上的成功,也为语音识别系统的语言模型优化提供了新的思路,通过引入预训练模型,可以显著提升语言模型的泛化能力和语义理解水平。

解码输出是语音识别的最终环节,其任务是在声学模型和语言模型的约束下,寻找最优的文本序列作为识别结果,常用的解码算法包括维特比算法和束搜索(Beam Search),维特比算法通过动态规划寻找全局最优路径,适用于HMM-based模型;而束搜索则在保证搜索效率的同时,维护多个候选路径,有效平衡了识别准确率和计算复杂度,对于端到端模型,CTC解码和注意力机制解码是主流方案,CTC引入了空白标签连接重复字符,实现了序列对齐的自动化;注意力机制则通过计算特征序列与文本序列之间的对齐权重,实现了端到端的序列转换。

随着技术的不断进步,语音识别在工业界的应用日益广泛,从智能助手、语音输入到实时字幕、语音转写等领域均发挥着重要作用,该技术仍面临诸多挑战,如口音差异、环境噪声、远场识别、语速变化等问题对识别准确率的影响,结合多模态信息、自监督学习和持续学习等技术,语音识别系统有望在复杂场景下实现更鲁棒的性能,为人机交互带来更加自然和智能的体验。

相关问答FAQs: 问:语音识别技术如何区分不同说话人的声音? 答:说话人识别技术(声纹识别)是语音识别的重要分支,通过提取说话人的个体特征(如基频、共振峰特性等)来区分不同说话人,在语音识别系统中,可以通过集成说话人模型或采用端到端的多人语音识别模型,结合说话人嵌入向量(Speaker Embedding)实现说话人分离与识别,在会议场景中,系统可以通过声纹特征区分不同发言人的语音,并为每人生成独立的转写文本。

问:语音识别在低资源语言(如少数民族语言)中面临哪些挑战? 答:低资源语言的语音识别主要面临数据稀缺、语言模型弱和标注成本高等挑战,由于训练数据不足,声学模型难以准确捕捉语音特征;语言模型缺乏足够的文本数据支持,导致语法和语义建模能力较弱,解决方案包括:迁移学习,将高资源语言的模型参数迁移到低资源语言;自监督学习,利用无标注语音数据预训练模型;半监督学习,结合少量标注数据和大量无标注数据提升模型性能;以及跨语言共享特征,通过多语言联合训练增强模型的泛化能力。