语音识别技术作为人工智能领域的重要分支,其核心在于将人类语音信号转化为可计算的文本或指令,而隐马尔可夫模型(HMM)作为传统语音识别系统的基石框架,为这一转化过程提供了坚实的数学基础和工程实现路径,从技术演进视角看,现代语音识别系统的构建往往以HMM为核心,融合声学模型、发音词典和语言模型三大模块,形成端到端的信号处理与语义理解闭环。

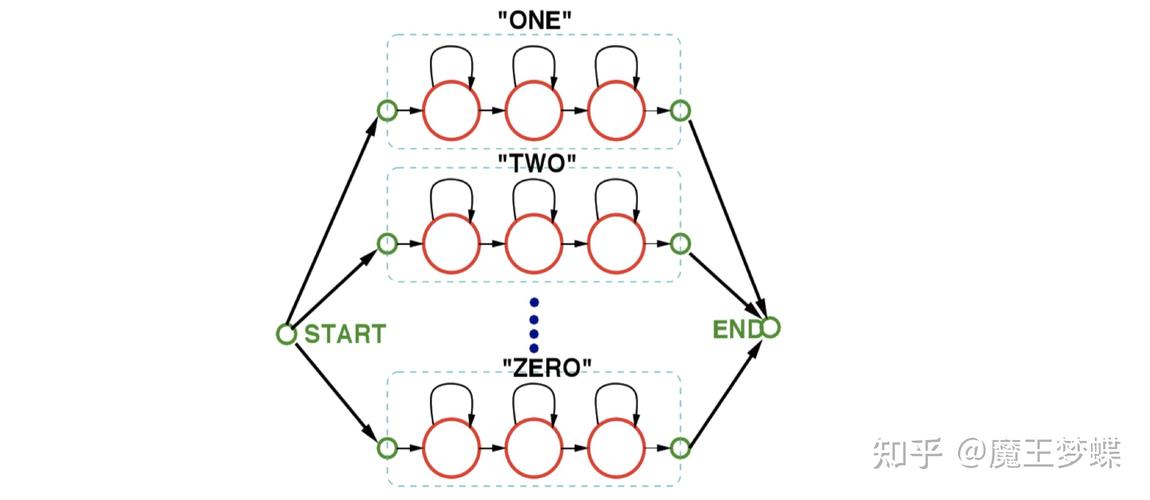

在声学建模层面,HMM通过状态转移概率和观测概率的双重机制刻画语音信号的动态特性,语音信号首先经过预加重、分帧、加窗等预处理操作,转化为短时频谱特征,如梅尔频率倒谱系数(MFCC),这些特征向量序列被视为HMM的观测序列,而每个音素(Phoneme)则被建模为一个HMM,包含3至5个隐状态,音素/a/对应的HMM可能经历“开-mouth元音共振峰建立-稳定-衰减”的状态转移路径,每个状态的高斯混合模型(GMM)输出观测概率密度,实际系统中,通常会采用连续概率密度HMM(CD-HMM),其中每个状态的概率分布由多个高斯函数加权混合而成,以适应语音特征的复杂分布特征,以英语单词“hello”为例,其音素序列/h/+/e/+/l/+/o/可对应4个HMM单元串联,每个单元的状态转移路径共同构成该词的声学模型拓扑结构。

发音词典作为连接音素与单词的桥梁,为HMM系统提供了基本的语言单元对应关系,词典中会明确“apple”对应/æ/+/p/+/ə/+/l/三个音素的序列,这种对应关系直接决定了HMM状态转移网络的构建基础,在汉语语音识别中,由于涉及声调信息,音素单元需扩展为声母-韵母-声调的三元结构,如“妈”对应/m/+/a/+/1/(阴平),其HMM模型需额外建模声调状态的转移特性。

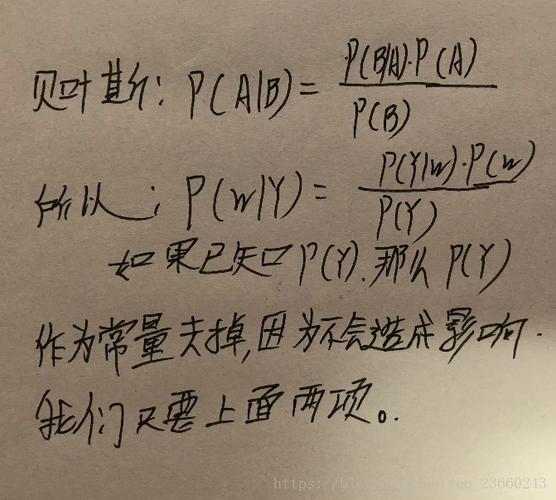

语言模型则通过统计概率约束HMM状态转移的合理性,解决同音词识别等歧义问题,以N-gram语言模型为例,其计算当前词序列w1,w2,...,wn的概率时,基于马尔可夫假设近似为P(wi|wi-1,...,wi-n+1)≈P(wi|wi-n+1,...,wi-1),在实际识别过程中,HMM解码器需结合声学模型得分logP(O|λ)和语言模型得分logP(W),通过维特比算法寻找最优词序列W*=argmaxW logP(O|λ)+logP(W),当语音信号同时对应“买”和“卖”两个同音词时,语言模型会根据上下文词汇概率(如“股票”后接“卖”的概率高于“买”)输出最终识别结果。

HMM在语音识别中的优势在于其强大的时序建模能力和成熟的数学工具支持,通过前向-后向算法可高效计算观测概率,通过Baum-Welch算法可实现模型参数的自适应优化,传统HMM系统也存在固有局限:一是强假设条件(如马尔可夫性、观测独立性)与实际语音信号的复杂性存在偏差;二是GMM-HMM框架中特征提取与模型训练分离,导致信息传递损失;三是状态空间随音素组合数量呈指数增长,计算复杂度较高,这些局限推动了深度学习技术与HMM的融合,如采用深度神经网络(DNN)替代GMM输出状态概率,形成DNN-HMM混合系统,使识别错误率相对传统GMM-HMM降低20%-30%。

从工程实践角度看,HMM语音识别系统的性能优化涉及多维度调参,声学模型方面,需平衡状态数量与训练数据量,通常每个音素设置3-5个状态,状态数过少会导致模型欠拟合,过多则易产生过拟合;GMM混合数的选择需根据特征维度确定,MFCC特征维度为39时,混合数通常设置为16-256,语言模型方面,N-gram的阶数需权衡模型精度与计算开销,常用3-gram或4-gram模型,并通过Kneser-Ney平滑技术解决数据稀疏问题,解码器实现中,为加速维特比搜索,常采用束搜索(Beam Search)策略,通过限制候选路径数量降低计算复杂度,典型束宽设置为50-200。

以下为HMM语音识别系统关键参数配置示例:

| 模块类型 | 关键参数 | 典型取值 | 优化目标 |

|---|---|---|---|

| 声学模型 | HMM状态数 | 3-5/音素 | 平衡模型复杂度与拟合能力 |

| GMM混合数 | 16-256 | 适应特征分布复杂性 | |

| 特征提取 | MFCC阶数 | 13 | 兼顾频谱信息与计算效率 |

| 帧长 | 25ms | 确保短时平稳性 | |

| 语言模型 | N-gram阶数 | 3-4 | 权衡上下文依赖与计算开销 |

| 平滑方法 | Kneser-Ney | 缓解数据稀疏问题 | |

| 解码器 | 束宽 | 50-200 | 控制搜索精度与速度 |

随着端到端模型(如CTC、Attention)的兴起,HMM在语音识别中的核心地位逐渐被取代,但其时序建模思想仍深刻影响着现代系统设计,CTC模型中的路径合并机制隐含了HMM的状态转移假设,而Transformer模型的时序注意力层可视为HMM状态转移的非线性扩展,在低资源场景或领域自适应任务中,HMM仍凭借其可解释性和参数高效性保持应用价值。

相关问答FAQs: Q1:为什么HMM在语音识别中需要结合GMM? A1:HMM的隐状态无法直接观测,需要通过观测概率分布来描述状态与特征的关系,GMM作为强大的概率密度估计工具,能够灵活拟合语音特征的复杂分布(如MFCC特征的 multimodal特性),而单一高斯分布无法满足这一需求,GMM-HMM通过将每个状态的观测概率建模为多个高斯函数的加权和,显著提升了声学模型的表征能力,这也是传统语音识别系统的标准配置。

Q2:HMM与深度学习结合的DNN-HMM相比纯HMM有哪些优势? A2:DNN-HMM的核心优势在于突破了HMM的强假设限制:一是DNN通过多层非线性变换自动提取特征,避免了手工设计MFCC等特征的信息损失;二是DNN能够建模高维特征间的复杂依赖关系,而GMM假设特征维度间独立,导致模型精度受限;三是DNN-HMM将声学建模与状态概率估计统一框架,实现端到端优化,相对传统GMM-HMM可降低20%-30%的词错误率,尤其在噪声环境、口音差异等复杂场景下,DNN的鲁棒性优势更为显著。