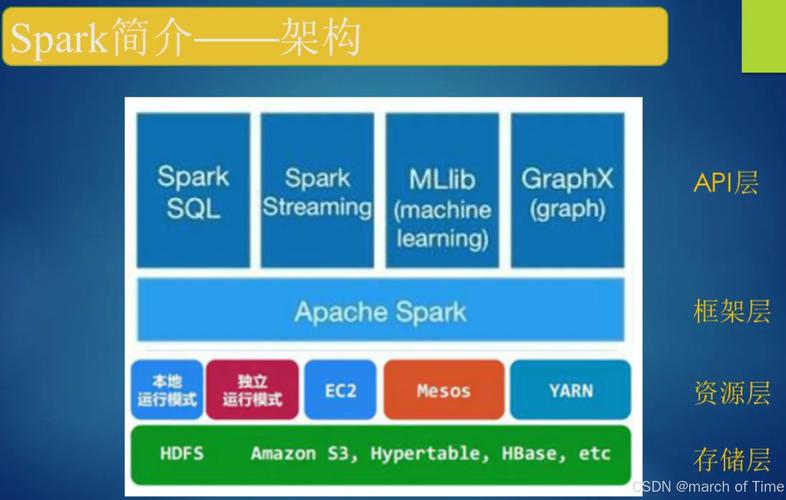

在当今大数据技术蓬勃发展的浪潮中,Apache Spark 作为开源分布式计算框架的佼佼者,已成为企业级数据处理的核心引擎,围绕 Spark 技术的学习、实践与交流,各类技术论坛应运而生,成为开发者、数据工程师和研究人员的重要阵地,这些论坛不仅汇聚了行业前沿动态,更通过深度讨论与经验分享,推动着 Spark 技术生态的持续繁荣。

Spark 技术论坛的核心价值在于其构建的多元化知识共享网络,从技术原理到实践案例,从版本迭代到问题排查,论坛内容覆盖了 Spark 技术栈的方方面面,以社区驱动的模式,论坛吸引了来自全球的开发者参与其中,无论是初学者提出的“本地模式运行失败”等基础问题,还是资深工程师探讨的“大规模集群资源优化”等高阶议题,都能在这里得到及时响应,这种开放、互助的交流氛围,极大降低了技术门槛,加速了知识传播,尤其对于希望快速掌握 Spark 的开发者而言,论坛堪称“实战宝典”。 维度来看,Spark 技术论坛通常划分为多个核心板块。“基础入门”板块聚焦于 Spark 核心概念解析,如 RDD、DataFrame、Dataset 的区别与应用场景,Spark 作业提交流程详解,以及 Scala/Python 编程基础等,这类内容常以图文教程、视频教程的形式呈现,配合新手常见问题(FAQ)合集,帮助初学者建立系统认知。“实战案例”板块则更具行业针对性,例如电商领域的用户行为分析、金融领域的实时风控模型、医疗领域的基因数据处理等,开发者通过分享具体项目的架构设计、代码实现与性能调优经验,为同行提供可复用的解决方案,某电商技术团队曾在论坛详细阐述如何基于 Spark Streaming 和 Kafka 构建实时推荐系统,包括数据分区策略、状态管理机制以及低延迟优化技巧,引发了热烈讨论。

“问题求助”是论坛中最活跃的板块,也是技术价值的集中体现,用户遇到的问题五花八门,从环境配置(如 Spark 与 Hadoop 版本兼容性问题)到性能瓶颈(如 shuffle 过程中的数据倾斜),从 API 使用(如 UDF 自定义函数优化)到集群管理(如 YARN 资源分配参数调优),针对这些问题,资深开发者往往会结合源码进行分析,不仅给出解决方案,更解释底层原理,帮助提问者举一反三,当用户反馈“Spark SQL 查询缓慢”时,有经验者会建议通过执行计划(EXPLAIN)分析算子优化,或利用广播变量(Broadcast Variable)减少数据 shuffle,甚至指导其通过 Spark UI 定位耗时任务,这种“授人以渔”的解答方式,有效提升了社区整体的技术水平。

除了问题解决,论坛还承载着技术前沿的传播功能,随着 Spark 不断迭代(如 3.0 版本引入的 AQE 自适应查询优化),官方团队成员和社区 KOL 会第一时间发布新特性解读、迁移指南和最佳实践,论坛还经常组织线上研讨会、编程竞赛等活动,促进理论与实践的结合,某知名云厂商曾在论坛发起“Spark 大数据处理挑战赛”,要求参赛者基于公开数据集完成 ETL 与分析任务,优胜者的解决方案不仅展示了 Spark 的强大能力,也为社区贡献了高质量代码。

为了更直观地展示 Spark 技术论坛的典型内容分类,以下表格列举了主要板块及其核心内容:

| 板块名称 | 目标用户 | |

|---|---|---|

| 基础入门 | Spark 核心概念、环境搭建、API 基础、入门教程 | 初学者、转行者 |

| 实战案例 | 行业解决方案、项目架构设计、性能调优经验、代码分享 | 中高级开发者、技术团队 |

| 问题求助 | 环境配置、错误排查、性能优化、API 使用疑难 | 所有用户,尤其是遇到瓶颈者 |

| 技术前沿 | 新版本特性解读、行业趋势分析、官方动态、学术研究成果 | 资深开发者、研究人员 |

| 资源分享 | 电子书、工具推荐、学习路径、行业报告 | 所有用户 |

Spark 技术论坛也面临一些挑战,信息过载可能导致优质内容被淹没,部分问题重复提问占用资源,以及技术深度与广度难以平衡,对此,优质论坛通常通过设立精华区、引入标签分类机制、鼓励专家认证等方式提升内容质量,许多论坛开始结合 AI 技术实现智能问答,通过自然语言处理快速匹配历史问题,提高解答效率。

总体而言,Spark 技术论坛作为技术社区的重要组成部分,不仅为开发者提供了学习与交流的平台,更通过集体智慧推动了 Spark 技术的创新发展,无论是新手入门的“引路人”,还是资深专家的“思想碰撞场”,论坛都在持续为大数据生态注入活力,随着 Spark 在机器学习(Spark MLlib)、图计算(GraphX)等领域的不断拓展,技术论坛的内容也将更加丰富,成为连接技术与产业的关键纽带。

相关问答 FAQs

-

问:在 Spark 技术论坛提问时,如何提高获得高质量回答的概率?

答:为提高提问效率,建议遵循“问题描述清晰、信息完整、步骤具体”的原则,明确说明使用的 Spark 版本、操作系统、集群环境(如 YARN/Standalone)等基本信息;详细复现问题现象,包括错误日志、关键代码片段及预期结果;已尝试的解决方案及结果也应一并说明,避免他人重复劳动,标题需简洁概括问题核心,便于快速定位,标题“Spark 3.0 on YARN 集群提交作业时出现 Container killed 问题”比“求助Spark运行失败”更易获得针对性解答。 (图片来源网络,侵删)

(图片来源网络,侵删) -

问:Spark 技术论坛中,如何区分“官方回答”与“社区经验分享”的可靠性?

答:论坛通常会通过标识区分用户身份,如“Apache Spark Committer”“社区认证专家”等,这类用户的回答通常具有较高的权威性,对于普通用户的经验分享,可结合以下标准判断:一是回答是否提供数据或案例支撑(如性能测试对比、实际项目效果);二是是否引用 Spark 官方文档或源码链接;三是其他用户的反馈(如点赞数、评论验证),若涉及关键生产环境问题,建议以官方文档为准,并优先参考有官方背景用户的建议,同时在小规模测试环境中验证解决方案的可行性。