语音识别技术实现方式

语音识别技术(Automatic Speech Recognition, ASR)是指将人类语音信号转换为文本或命令的技术,其核心目标让机器能够“听懂”人类语言,随着人工智能和深度学习的发展,语音识别技术在准确率、鲁棒性和应用场景上取得了突破性进展,其实现方式涉及信号处理、声学建模、语言建模等多个环节,是一个复杂的系统工程,以下从技术原理、核心流程、关键模块及发展趋势等方面详细阐述语音识别技术的实现方式。

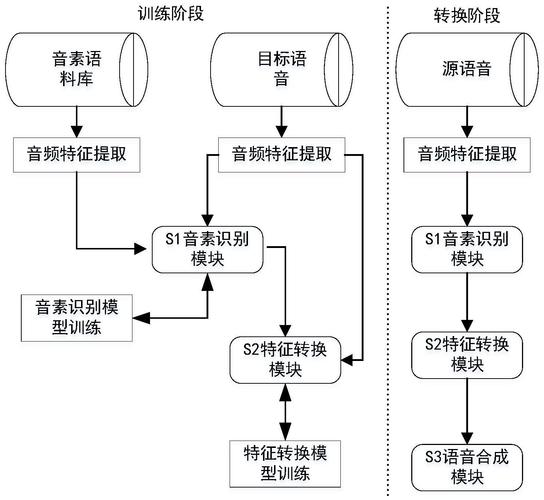

语音识别的核心技术流程

语音识别的实现过程可分为预处理、特征提取、声学模型、语言模型、解码搜索等主要步骤,每个环节的优化都直接影响识别效果。

语音预处理

原始语音信号通常是模拟信号,包含噪声、混响、说话人差异等干扰因素,需通过预处理进行净化和标准化,主要包括:

- 预加重:通过高通滤波器增强语音信号中的高频成分,补偿语音发声过程中声带和嘴唇辐射引起的能量衰减,通常使用一阶滤波器,传递函数为 ( H(z) = 1 - \alpha z^{-1} )((\alpha) 一般取0.9-1.0)。

- 分帧加窗:语音信号具有非平稳性,需将其短时平稳化,通常将信号划分为20-40ms的帧,帧移10-20ms,并采用汉明窗(Hamming Window)或汉宁窗(Hanning Window)减少频谱泄漏。

- 端点检测:识别语音段的起止点,剔除静音部分,减少计算量,常用方法基于能量、过零率或结合深度学习的端点检测模型。

特征提取

特征提取是从语音信号中提取能反映语音本质的特征参数,为后续声学建模提供输入,主流特征包括:

- 梅尔频率倒谱系数(MFCC):模拟人耳听觉特性,通过梅尔滤波器组将频谱转换为梅尔尺度,再取对数和离散余弦变换(DCT)得到,通常包含13-39维系数,一阶和二阶差分特征构成39维特征向量。

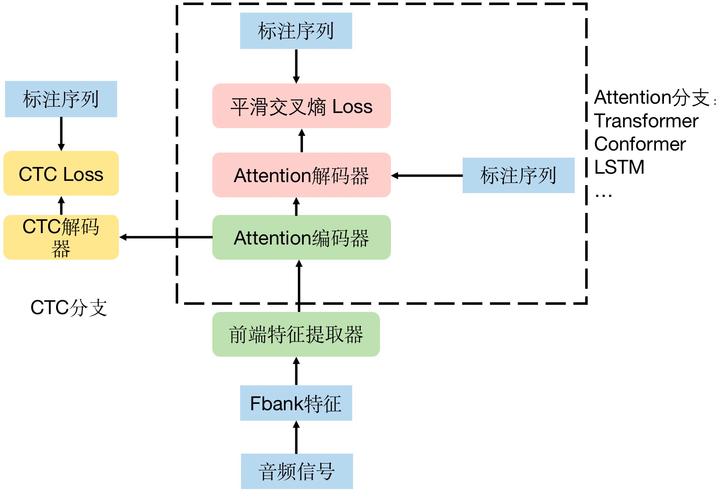

- 滤波器组特征(FBank):直接通过梅尔滤波器组输出对数能量谱,省略DCT步骤,保留更多频谱信息,在端到端模型中应用广泛。

- 声学特征与深度特征融合:传统特征与深度神经网络(DNN)提取的特征结合,如MFCC与 bottleneck层特征融合,提升模型对复杂语音的建模能力。

声学模型

声学模型是语音识别的核心,用于将语音特征映射为音素、音节或音素状态等声学单元,其发展经历了从统计模型到深度学习模型的演进:

- 隐马尔可夫模型-高斯混合模型(HMM-GMM):早期主流方法,HMM建模语音序列的时序动态性,GMM建模每个状态下的特征概率分布,需大量人工标注数据,且特征工程复杂。

- 隐马尔可夫模型-深度神经网络(HMM-DNN):DNN替代GMM输出状态概率,HMM建模时序依赖,DNN通过多层非线性变换提升特征表示能力,识别准确率显著提高。

- 端到端模型:直接从语音特征映射到文本,简化传统流程,主要包括:

- CTC(Connectionist Temporal Classification):引入_blank_标签处理时序对齐问题,支持序列到序列的直接建模,如LSTM-CTC模型。

- Attention-based模型:通过注意力机制对齐语音特征与文本序列,如LAS(Listen Attend Spell)模型,无需显式建模时序依赖。

- Transformer模型:利用自注意力机制(Self-Attention)捕捉长距离依赖,如Conformer模型,结合卷积神经网络(CNN)提取局部特征和注意力机制建模全局依赖,成为当前主流。

语言模型

语言模型用于评估文本序列的合理性,约束解码过程,纠正声学模型的歧义,常见模型包括:

- N-gram模型:基于马尔可夫假设,计算词序列的联合概率 ( P(w_1, w_2, ..., w_n) = \prod P(wi|w{i-n+1}, ..., w_{i-1}) ),通过大规模语料库统计词频,但存在数据稀疏问题,需平滑技术(如Kneser-Ney平滑)。

- 神经网络语言模型(NNLM):如前馈神经网络、循环神经网络(RNN)或Transformer,通过分布式表示解决数据稀疏问题,能捕捉长距离依赖,在端到端模型中与声学模型联合训练。

解码搜索

解码搜索是指在声学模型和语言模型的约束下,寻找最优文本序列的过程,常用算法包括:

- 维特比算法(Viterbi):基于HMM的动态规划算法,寻找最可能的状态序列,适用于HMM-GMM/HMM-DNN模型。

- 前束搜索(Beam Search):在解码过程中保留概率最高的多个候选路径,平衡搜索效率与准确性,广泛应用于端到端模型。

- 启发式搜索:结合语言模型权重、长度惩罚等策略,优化解码结果,如Shallow Fusion技术(声学模型与外部语言模型融合)。

语音识别的关键技术模块

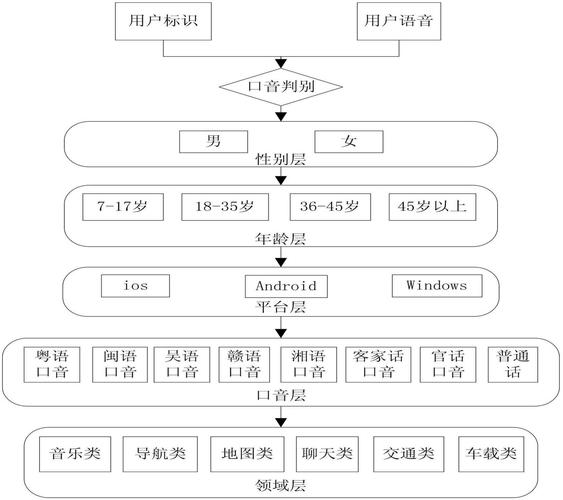

说话人自适应技术

针对不同说话人的口音、语速差异,通过自适应方法调整模型参数,主要包括:

- 最大后验概率(MAP):利用少量目标说话人数据更新模型参数。

- 最大似然线性回归(MLLR):通过线性变换映射模型均值,适应新说话人特征。

- 基于深度学习的自适应:如多任务学习、元学习,在模型训练中引入说话人标识,提升泛化能力。

噪声与混响鲁棒性

实际场景中噪声、混响会严重影响识别效果,常用增强方法包括:

- 信号级增强:谱减法、维纳滤波、深度学习去噪(如RNNoise、SEGAN)。

- 特征级增强:相对谱幅度(RASTA)滤波、特征归一化(CMN、FMN)。

- 模型级增强:在训练中模拟噪声环境(如语音增强预训练)、多任务学习(联合训练识别与增强任务)。

多模态融合

结合视觉信息(如唇动)提升识别鲁棒性,尤其在噪声环境下,典型模型为音频-视觉语音识别(AV-ASR),通过跨模态注意力机制融合音频特征与视觉特征。

语音识别技术的实现挑战与发展趋势

挑战

- 低资源语言场景:小语种或方言数据不足,导致模型性能受限。

- 复杂环境适应性:强噪声、远场、多人对话等场景下识别准确率下降。

- 实时性与资源消耗:端到端模型计算量大,需优化推理速度以满足实时需求。

- 个性化与隐私保护:用户语音数据的隐私安全与个性化模型训练的平衡。

发展趋势

- 自监督学习:如 wav2vec 2.0、HuBERT,通过无标注数据预训练,减少对标注数据的依赖。

- 大语言模型(LLM)融合:将语音识别与LLM结合,利用LLM的语义理解能力提升识别准确率,如GPT-4语音交互系统。

- 边缘计算部署:通过模型压缩(量化、剪枝)、知识蒸馏等技术,将轻量级模型部署于终端设备(如手机、智能音箱)。

- 多语言与代码转换:统一模型支持多语言识别,实现语音与编程语言的转换(如语音生成代码)。

相关问答FAQs

问题1:语音识别中的端到端模型与传统HMM-GMM模型相比有哪些优势?

解答:端到端模型(如CTC、Attention、Transformer)直接从语音特征映射到文本,简化了传统HMM-GMM中声学模型、发音词典、语言模型的多模块串联流程,其优势包括:1)减少人工特征工程依赖,自动学习有效特征;2)联合优化声学和语言模型,提升全局最优性;3)处理长序列和复杂上下文依赖能力更强,识别准确率更高,尤其在远场、噪声环境下表现更优,但端到端模型通常需要更多训练数据和计算资源,且可解释性较差。

问题2:如何提升语音识别在强噪声环境下的鲁棒性?

解答:提升强噪声环境下的鲁棒性需从数据、模型、算法多层面入手:1)数据增强:在训练中添加真实噪声或合成噪声(如添加噪声、混响扰动),模拟实际场景;2)前端信号处理:采用深度学习去噪模型(如RNNoise、SEGAN)或语音增强算法(如谱减法、维纳滤波)预处理语音;3)模型优化:使用鲁棒性特征(如FBank替代MFCC)、引入多任务学习(联合训练识别与去噪任务)、或采用对抗训练提升模型抗干扰能力;4)多模态融合:结合视觉信息(如唇动识别)辅助语音识别,尤其在噪声环境下显著提升性能。