HBM显存作为一种高性能内存技术,通过独特的架构设计和先进制造工艺,在带宽、功耗和密度等关键指标上实现了突破,成为现代高端计算、人工智能训练和数据中心的核心组件,其技术特点主要体现在以下几个方面:

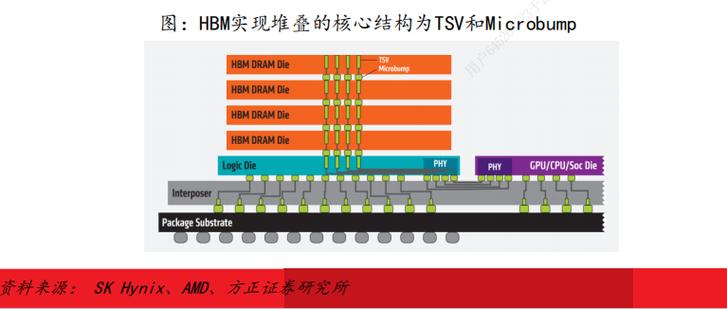

3D堆叠技术是HBM的核心基础,与传统显存(如GDDR)采用2D平面封装不同,HBM通过硅通孔(TSV)技术将多个DRAM芯片垂直堆叠在一起,并与一个基板(通常为硅中介层)连接,这种3D结构显著减少了信号传输距离,同时能够在有限空间内集成更多存储单元,HBM2E可将16个DRAM堆叠至12层高度,存储容量高达8GB per stack,而传统GDDR6显存的单颗芯片容量通常仅为16GB或32GB,堆叠后的裸片通过微凸块与中介层互连,进一步提升了集成度和信号完整性。

超宽位宽设计大幅提升了数据传输带宽,HBM采用通道化并行传输架构,每个堆叠芯片包含多个独立通道(如HBM2E为8通道),每个通道位宽可达512bit,与传统GDDR显存的32bit或64bit通道相比,HBM的总位宽可达1024bit或2048bit,配合高频率运行(如HBM2E频率达2.4Gbps),可实现高达3.2TB/s的惊人带宽,这种宽位宽设计减少了数据传输的瓶颈,特别适合处理大规模并行计算任务,如AI模型训练中的矩阵运算和高分辨率图形渲染中的纹理加载。

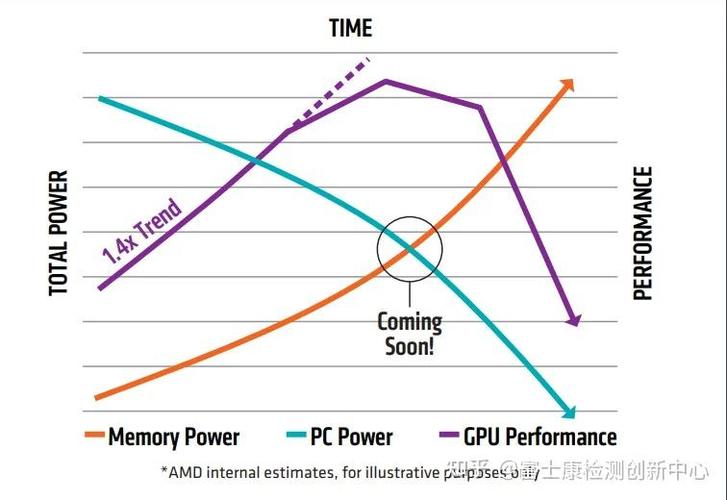

第三,低功耗特性是HBM的另一大优势,由于3D堆叠缩短了信号路径,HBM的工作电压显著低于传统显存(HBM2E为1.2V,而GDDR6为1.35V),同时无需像GDDR那样依赖高频运行来提升带宽,从而降低了整体功耗,同样提供1TB/s带宽的HBM2E显存功耗约为20W,而GDDR6则需要约50W,HBM采用先进的电源管理技术,支持动态电压频率调节(DVFS),可根据负载需求灵活调整功耗,进一步提升了能效比。

第四,高密度与小型化设计满足了紧凑型设备的需求,通过3D堆叠和裸片直接键合(DBI)技术,HBM在相同面积下实现了更高的存储密度,一个HBM2E堆叠模块尺寸仅为31mm×31mm,却能提供8GB容量和3.2TB/s带宽,而同等带宽的传统GDDR6显存需要占用更大的PCB空间,这种小型化设计使得HBM能够直接集成在GPU或SoC的封装内部,通过中介层实现与计算核心的高效互连,缩短了延迟并提升了系统稳定性。

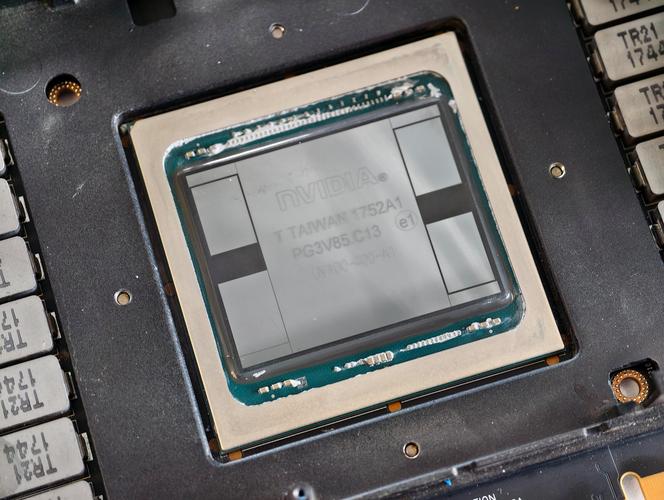

第五,先进封装与互连技术确保了高性能与可靠性,HBM采用硅中介层(Interposer)作为核心互连介质,中介层上布满了密集的微凸块,用于连接GPU核心与HBM堆叠,这种设计实现了超短距离的信号传输(通常小于100μm),有效降低了信号衰减和串扰,HBM支持多堆叠扩展(如HBM3可支持12个堆叠),通过PoP(Package-on-Package)或Co-Packaged(共封装)方式,进一步提升了系统整体的存储容量和带宽。

标准化与可扩展性推动了HBM的广泛应用,从HBM1到HBM3,JEDEC(固态技术协会)持续完善技术标准,确保不同厂商的HBM芯片兼容性,HBM3在HBM2E基础上进一步提升了频率(可达6.4Gbps)和堆叠层数(可达16层),带宽突破8TB/s,同时支持更低的功耗和更高的可靠性,为下一代AI超级计算机和图形处理器提供了强大支持。

相关问答FAQs

Q1:HBM与传统GDDR显存的主要区别是什么?

A:HBM与GDDR的核心区别在于架构和性能设计,HBM采用3D堆叠技术,通过TSV和中介层实现高带宽、低功耗,位宽可达1024bit以上,带宽最高8TB/s;而GDDR采用2D平面封装,依赖高频运行提升带宽,位宽通常为32bit或64bit,功耗较高,HBM体积更小,适合紧凑型设备,而GDDR成本较低,适用于消费级显卡。

Q2:HBM显存的主要应用场景有哪些?

A:HBM显存主要用于对带宽和功耗要求极高的领域,包括:1)高端AI训练与推理,如GPU、TPU等加速卡,支持大规模模型训练;2)高性能计算(HPC),如科学模拟、气象预测等并行计算任务;3)专业图形工作站,用于8K视频编辑、3D渲染等;4)数据中心服务器,提升虚拟化和云计算的效率,随着技术迭代,HBM也逐渐向高端消费级显卡渗透。