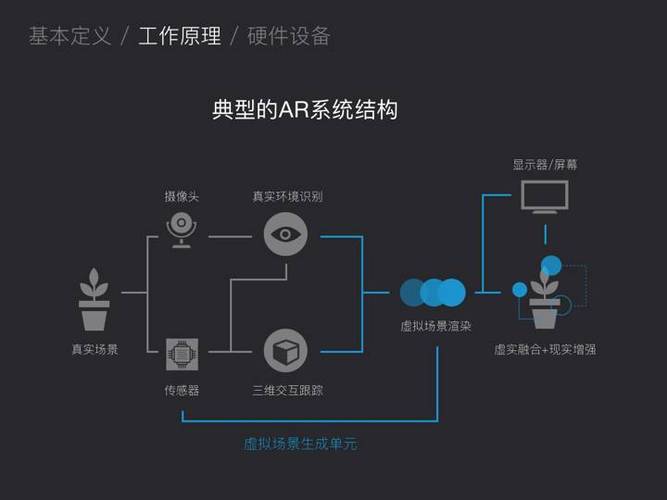

手机AR技术的核心在于通过手机的摄像头、传感器和计算能力,将虚拟数字信息与真实世界环境实时融合,让用户在手机屏幕上看到叠加在现实场景中的虚拟内容,其具体原理涉及硬件感知、数据处理、渲染显示和交互反馈等多个环节的协同工作,以下从技术架构和实现流程展开详细说明。

硬件感知:捕捉现实世界的“输入层”

手机AR的实现首先需要获取真实环境的信息,这依赖于手机的多类传感器协同工作:

- 摄像头:作为主要视觉输入设备,摄像头实时拍摄现实世界的视频流,为AR系统提供连续的图像帧,现代手机通常配备多摄像头(广角、超广角、长焦等),结合深度传感器(如结构光或飞行时间传感器TOF),可实现深度信息的采集,帮助系统理解场景中物体的距离和空间关系。

- 惯性测量单元(IMU):包含加速度计和陀螺仪,用于实时监测手机的姿态变化(如旋转、加速度),加速度计检测手机在三维空间中的线性运动,陀螺仪测量角速度,两者结合可精确计算设备的朝向和位置变化,这是虚拟物体与现实场景对齐的关键。

- GPS、磁力计和气压计:GPS提供设备的绝对位置信息,用于大范围AR场景的定位(如导航类AR);磁力计(电子罗盘)辅助判断设备朝向;气压计通过气压变化测量海拔高度,增强空间定位的精度,尤其在室内或GPS信号弱的场景中。

这些传感器数据以高频(如100Hz以上)同步采集,确保系统对现实环境的感知实时且准确,当用户手持手机移动时,IMU数据会实时更新设备姿态,摄像头画面随之同步调整,避免虚拟图像与现实场景出现错位。

数据处理:从“图像”到“空间理解”的核心

硬件采集的原始数据(图像、姿态、位置等)需经过复杂的处理,才能转化为可叠加虚拟内容的“数字空间”,这一过程主要包括以下几个关键步骤:

图像预处理与特征提取

摄像头拍摄的图像首先经过预处理,包括去噪、色彩校正、畸变校正(消除镜头畸变)等,确保图像质量,随后,系统通过计算机视觉算法提取图像中的特征点,如SIFT、SURF或ORB算子,这些特征点是图像中独特的角点、边缘或纹理区域,用于后续的图像匹配和场景识别。

运动追踪与场景重建

- 运动追踪:基于连续图像帧之间的特征点匹配,结合IMU数据,通过SLAM(即时定位与地图构建)技术估算设备在空间中的运动轨迹(位置和姿态),SLAM算法通过“跟踪-地图更新”的循环机制,实时构建环境的空间模型,同时确定设备在模型中的位置,当手机水平移动时,SLAM算法通过匹配前后帧的特征点,计算出设备在X、Y轴上的位移,并结合陀螺仪数据调整Z轴高度。

- 场景理解:通过深度学习模型(如YOLO、Mask R-CNN)识别图像中的物体类别(如桌子、地面、人脸)、平面(地面、墙面)或空间结构,AR应用可识别出桌面平面,并将虚拟物体(如杯子)稳定地放置在桌面上,避免出现“漂浮”现象。

空间定位与对齐

在获得设备姿态和场景空间模型后,系统需要将虚拟坐标系与现实坐标系对齐,这一过程涉及:

- 坐标转换:将虚拟物体的三维坐标(如虚拟模型的XYZ位置)通过投影矩阵转换为手机屏幕的二维坐标,确保虚拟物体与现实场景在透视、比例上一致,当手机倾斜时,虚拟物体的投影角度会随之变化,模拟真实世界的透视效果。

- 光照估计:通过分析现实场景的光照条件(如光源方向、颜色、强度),对虚拟物体的材质和光照效果进行匹配,使虚拟物体看起来更自然,在室外强光下,虚拟物体的阴影和高光会增强,与真实环境的光照一致。

渲染显示:虚拟与现实的“视觉融合”

处理完成的虚拟内容需通过手机的显示模块呈现,这一过程涉及图形渲染和显示技术:

- 图形渲染:手机GPU(图形处理器)负责实时渲染虚拟物体,通常采用OpenGL ES或Vulkan等图形API,渲染过程包括几何变换、纹理映射、光照计算等,最终生成包含虚拟内容的图像帧,在AR游戏中,GPU会实时渲染3D角色模型,并根据场景光照调整其表面颜色和阴影。

- 图像融合:渲染完成的虚拟图像帧与摄像头拍摄的现实图像帧通过透明度混合(Alpha Blending)技术叠加,形成最终的AR画面,系统会根据虚拟物体的深度信息(如距离镜头的远近)调整渲染顺序,确保前后遮挡关系正确(虚拟物体在真实物体后方时会被遮挡)。

- 显示优化:为降低延迟,现代AR应用采用“预渲染”技术:在摄像头数据到达前,GPU根据预测的设备姿态预先渲染部分虚拟内容,待真实数据到达后快速完成融合,确保画面流畅(通常要求延迟低于20ms),高刷新率屏幕(如90Hz/120Hz)可减少画面卡顿,提升AR体验的沉浸感。

交互反馈:用户与虚拟世界的“沟通”

AR技术不仅需要“显示”,还需支持用户与虚拟内容的交互,手机通过以下方式实现交互反馈:

- 触摸交互:用户直接触摸屏幕,系统通过触摸坐标与虚拟物体坐标的匹配,实现点击、拖拽等操作,在AR购物应用中,用户可触摸虚拟家具模型,调整其大小或位置。

- 手势识别:通过前置摄像头捕捉用户手势,结合计算机视觉算法识别特定动作(如挥手、捏合),触发相应功能,用户捏合手势可放大虚拟物体,挥手可切换AR场景。

- 语音与传感器交互:语音助手(如Siri、小爱同学)可接收语音指令控制AR内容;重力传感器、陀螺仪等则支持“晃动手机”等交互方式。

技术挑战与优化方向

尽管手机AR技术已较为成熟,但仍面临诸多挑战:

- 功耗与性能平衡:SLAM算法和图形渲染消耗大量电量,需通过硬件加速(如NPU专用AI芯片)和算法优化(如轻量化SLAM模型)降低功耗。

- 环境适应性:在弱光、无纹理场景(如纯白墙面)或快速运动时,特征点提取困难,导致追踪丢失,解决方案包括融合多传感器数据(如WiFi/蓝牙辅助定位)和引入深度学习提升场景鲁棒性。

- 空间一致性:大范围AR场景中,长期追踪易出现累积误差,需通过云端地图共享或视觉闭环检测修正位置偏差。

相关问答FAQs

Q1:手机AR技术需要联网吗?

A1:不一定,基础的AR功能(如虚拟物体放置、简单追踪)可在本地完成,无需联网,但复杂功能(如云端3D模型加载、多人AR交互)需依赖网络支持,AR游戏中的实时多人对战需要云服务器同步数据,而离线的AR导航应用则可完全本地运行。

Q2:为什么有些AR应用在暗光环境下效果变差?

A2:暗光环境下,摄像头采集的图像信噪比降低,特征点提取困难,导致SLAM算法追踪精度下降,部分手机依赖屏幕环境光传感器调整AR渲染亮度,暗光时屏幕亮度不足也会影响视觉效果,为改善体验,用户可开启手机闪光灯,或选择支持红外辅助感知的设备(如iPhone的LiDAR扫描仪)。