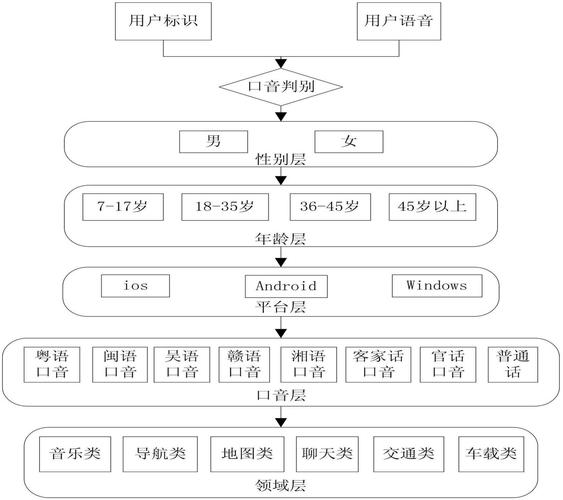

可以把语音识别想象成教一个“机器人”听懂人说话的过程,这个过程非常复杂,但核心可以概括为几个关键步骤,现代主流的语音识别技术几乎都基于深度学习,特别是端到端模型。

下面我将从传统方法讲起,然后重点讲解现代深度学习方法的原理,因为它更贴近当前的实际应用。

核心思想:从声音到文字的转换

无论技术如何演进,语音识别的根本任务都是一样的:将一段声波信号(音频)转换成一段对应的文字序列,这本质上是一个模式识别问题,需要识别出声波中蕴含的语言模式。

传统方法(早期技术,现已基本被取代)

在深度学习兴起之前,语音识别主要依赖高斯混合模型-隐马尔可夫模型,它是一个“多模块”的流水线,大致分为三步:

-

特征提取:

(图片来源网络,侵删)

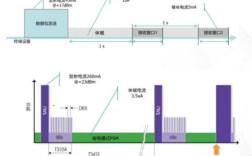

(图片来源网络,侵删)- 问题:原始的音频信号是一长串连续的数字点,直接处理计算量巨大且不稳定(男声和女声的频率范围不同)。

- 解决:将音频信号转换成一种能代表其声学特征的、更紧凑的表示,最经典的算法是梅尔频率倒谱系数。

- 类比:这就像你听交响乐时,不会去记住每个声波的精确频率,而是会注意到“小提琴在拉高音”、“大鼓在敲低音”,MFCC就是提取这种“音高”、“音色”等关键特征。

-

声学模型:

- 问题:如何将提取出的特征与语言中的基本单元(如音素)对应起来?如何判断一串特征是“a”音还是“b”音?

- 解决:使用高斯混合模型-隐马尔可夫模型。

- 隐马尔可夫模型:它把语音的产生过程看作一个“隐状态”序列,这个“隐状态”可以理解为发音时的不同生理状态(如嘴唇、舌头、声带的位置),我们听到的声音是这些状态产生的“观测结果”,HMM擅长描述这种“状态-观测”的动态过程。

- 高斯混合模型:对于每一个“隐状态”(比如发“k”这个音),它产生的观测结果(MFCC特征)并不是一个简单的点,而是围绕某个中心分布的,GMM用多个高斯分布的混合来描述这个复杂的概率分布。

- 类比:想象一个猜词游戏,HMM定义了每个字母(隐状态)被说出来的声音特征(观测结果)是什么样的概率分布,当我说“C”时,你的耳朵收到的声音特征,有80%的概率符合GMM-1,15%符合GMM-2... GMM-HMM模型就是用来计算“给定一段声音特征,它最可能对应哪个字母(音素)”的概率。

-

语言模型:

- 问题:声学模型只能孤立地判断每个音素,但很多音素在连读时发音会变化("what are you" 会连读成 "whatcha"),即使声学模型识别对了,也可能产生不合语法的句子。

- 解决:引入语言模型,它负责评估一个词序列出现的“可能性”或“自然度”。

- 方法:最常用的是N-gram模型,它基于一个简单的假设:一个词出现的概率只和它前面的 N-1 个词有关,在二元模型(Bigram, N=2)中,“后面接“天气”的概率很高,但接“香蕉”的概率就很低。

- 作用:语言模型会“惩罚”那些在语法上不通顺或不符合语言习惯的识别结果,声学模型可能把 "I scream" 和 "ice cream" 的声音特征都识别得差不多,但语言模型会告诉你,“I want to eat ice cream” 是一个合理的句子,而 “I want to eat I scream” 是一个荒谬的句子。

传统方法的缺点:流程繁琐,特征工程依赖专家经验,且声学模型和语言模型是分开训练和优化的,容易产生误差累积。

现代方法:基于深度学习的端到端模型

这是目前最主流、效果最好的方法,它彻底抛弃了传统方法的“多模块”流水线,试图让模型一次性完成从音频到文字的转换,就像一个“黑箱”一样。

其核心思想是:使用一个强大的神经网络,直接学习从原始声谱图到文本序列的映射关系。

核心组件:编码器-解码器 架构

大多数端到端模型都采用这种架构,其中最著名的是 LAS (Listen, Attend, Spell) 模型和 RNN-Transducer 模型,我们以 Transformer 架构(如 OpenAI 的 Whisper)为例来解释,因为它代表了当前最先进的技术。

-

编码器 - “倾听者”

- 输入:不再是孤立的MFCC特征,而是更丰富的声谱图,声谱图是将音频信号进行傅里叶变换后得到的二维图像,横轴是时间,纵轴是频率,颜色深浅代表能量大小,它保留了音频的时序和频率信息。

- 处理:编码器通常由多个Transformer层堆叠而成。

- 自注意力机制:这是Transformer的核心,在处理声谱图的某一帧时,自注意力机制会计算出它与声谱图中所有其他帧的“相关性”或“重要性”,这使得模型能够捕捉到长距离的依赖关系,识别一个词的尾音时,它可以“回头看”到这个词的开头,从而做出更准确的判断,这解决了传统RNN模型处理长序列时容易遗忘的问题。

- 前馈神经网络:对注意力机制处理后的特征进行进一步的非线性变换。

- 输出:编码器将输入的声谱图转换成一个高维的、包含丰富上下文信息的特征序列,这个序列可以被理解为“模型听懂了什么”。

-

解码器 - “书写者”

- 输入:它是一个自回归模型,意味着它需要一个词一个词地生成文本,在生成第

i个词时,它的输入是:已经生成的前i-1个词,以及从编码器那里得到的整个声学特征序列。 - 处理:解码器同样也使用Transformer层,但它的注意力机制更复杂,包含两种:

- 自注意力:关注已经生成的前

i-1个词之间的依赖关系(确保主语和动词的单复数一致)。 - 编码器-解码器注意力:这是关键一步,它让解码器在生成当前词时,能够“聚焦”到编码器输出的特征序列中最相关的部分,当解码器要生成“苹果”这个词时,它会去关注声谱图中与“苹果”发音最匹配的那几帧特征。

- 自注意力:关注已经生成的前

- 输出:解码器每一步都会输出一个概率分布,表示下一个最可能出现的词是什么,它会选择概率最高的那个词(或进行采样),并将其作为下一步的输入,直到生成一个表示句子结束的符号(如

<eos>)为止。

- 输入:它是一个自回归模型,意味着它需要一个词一个词地生成文本,在生成第

端到端模型的巨大优势

- 简化流程:无需手动设计特征(如MFCC),也无需分离声学模型和语言模型,模型自己学习从原始数据到最终结果的全部映射。

- 性能更优:由于模型是联合优化的,它能够更好地处理声学信息和语言信息的交互,识别准确率远超传统方法。

- 鲁棒性更强:能更好地处理口音、噪音、连读等真实世界中的复杂情况。

总结与类比

为了让您更直观地理解,我们可以做一个简单的类比:

| 技术环节 | 传统方法 (GMM-HMM) | 现代端到端方法 (如 Transformer) |

|---|---|---|

| 角色 | 一支分工明确的团队 | 一位经验丰富的“同声传译”专家 |

| 输入 | 原始音频信号 | 声谱图(音频的“图像”) |

| 特征提取 | MFCC工程师:手动提取音高、音色等特征。 | 模型自动学习:编码器通过自注意力,自己理解声音的细节和上下文。 |

| 声学模型 | 声学分析师:用GMM-HMM判断每个音素是什么。 | 编码器:将声谱图转换成富含信息的特征向量,交给“书写者”。 |

| 语言模型 | 语法校对员:用N-gram检查句子是否通顺。 | 解码器:一边“听”(看编码器特征),一边“写”(生成文本),并利用注意力机制确保语法和语义连贯。 |

| 输出 | 文字 | 文字 |