人脸识别技术的实现并非单一技术的堆砌,而是融合了计算机视觉、机器学习、光学工程、传感器技术、数据科学等多个领域的综合性成果,其核心依赖可从技术原理、硬件基础、数据支撑、算法模型及安全伦理五个维度展开分析。

技术原理:多模态感知与特征匹配

人脸识别的本质是通过提取人脸的视觉特征,与数据库中的预存特征进行比对,实现身份验证或识别,这一过程依赖三大核心技术模块:

- 人脸检测:在复杂场景中定位人脸位置,排除干扰物,传统方法基于Haar特征级联分类器或HOG特征,当前主流采用深度学习模型(如MTCNN、YOLO系列),通过边缘计算实现实时检测,准确率可达99%以上,检测过程需依赖人脸的固有特征:如双眼对称性、肤色聚类性、五官轮廓梯度等。

- 关键点定位:标定眼睛、鼻子、嘴角等68/106个关键点(如dlib库的5点模型),为后续对齐提供坐标基准,关键点定位的精度直接影响识别鲁棒性,例如当头部旋转±30°时,通过仿射变换对齐人脸,可减少姿态变化带来的特征偏差。

- 特征提取与匹配:通过卷积神经网络(CNN)将人脸图像映射为高维特征向量(如128/512维),常用模型包括FaceNet的Triplet Loss、ArcFace的Additive Angular Margin Loss,通过度量学习使同类特征距离最小化、异类特征距离最大化,匹配阶段采用余弦相似度或欧氏距离,设定阈值(如0.3)判断是否为同一人。

硬件基础:多传感器协同与算力支撑

硬件是人脸识别的物理载体,其性能决定了系统的响应速度与适用场景:

- 图像采集设备:可见光摄像头是最基础的传感器,其分辨率(如1080P/4K)、帧率(30fps/60fps)直接影响图像质量,为应对暗光环境,需搭配红外补光(940nm波长不可见光)或ToF(飞行时间)传感器,通过结构光或双目立体视觉获取深度信息,提升活体检测能力,iPhone的Face ID结合红外摄像头、泛光照明器和点阵投影器,构建3D人脸模型。

- 计算单元:边缘设备(如手机、门禁终端)采用NPU(神经网络处理器)或GPU加速推理,例如华为麒麟芯片的达芬奇架构可实现0.3秒内的人脸识别,云端系统则依赖GPU集群(如NVIDIA V100)进行模型训练,处理海量数据。

- 辅助传感器:在复杂场景中,需结合IMU(惯性测量单元)检测头部姿态,或麦克风进行声纹验证,构建多模态识别系统,降低单模态被攻击的风险(如照片、视频欺骗)。

数据支撑:海量标注与质量优化

数据是算法训练的“燃料”,其规模与质量直接决定模型泛化能力:

- 数据规模:主流公开数据集如LFW(Labeled Faces in the Wild)包含1.3万张人脸图像,MS-Celeb-1M拥有1000万张 celebrity 图像,工业级系统需数千万至亿级标注数据,旷视科技自建的人脸数据库覆盖不同年龄、种族、光照条件,使模型在非约束场景下保持95%以上准确率。

- 数据标注:需进行边界框标注、关键点标注、身份标签标注,部分场景需活体标注(如真实人脸与面具、照片的区分),半监督学习(如FixMatch)可减少人工标注成本,但需确保数据分布一致性。

- 数据增强:通过旋转(±15°)、遮挡(随机矩形遮挡)、噪声(高斯噪声)等模拟真实场景,防止过拟合,GAN(生成对抗网络)可生成合成人脸,扩充小样本类别(如特定人群)。

算法模型:深度学习驱动的迭代优化

算法是人脸识别的“大脑”,其演进经历了从传统机器学习到深度学习的跨越:

- 传统算法:PCA(主成分分析)将人脸投影到低维空间,LBP(局部二值模式)提取纹理特征,但对光照、姿态敏感,准确率不足90%。

- 深度学习算法:

- 特征提取网络:VGGNet、ResNet通过深层卷积提取层次化特征,ResNet-50在LFW上达到99.6%准确率。

- 损失函数设计:FaceNet的Triplet Loss拉近同类特征,推远异类特征;ArcFace引入角度间隔,提升特征判别性。

- 轻量化模型:MobileFaceNet、ShuffleNetV2针对移动端设计,参数量减少50%以上,同时保持95%准确率。

- 多模态融合:结合红外与可见光图像,通过双流CNN融合特征,提升夜间识别性能;结合姿态估计网络(HRNet),实现大角度人脸识别。

安全与伦理:对抗攻击与隐私保护

技术落地需兼顾安全性与伦理合规:

- 活体检测:通过动作检测(眨眼、张嘴)、纹理分析(皮肤反光)、3D结构光等方式,防止伪造攻击,苹果Face ID的3D建模可抵御平面照片攻击,误识率低于1/100万。

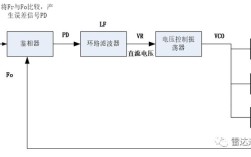

- 隐私保护:采用联邦学习(Federated Learning)实现数据不出域训练,或差分隐私(Differential Privacy)在特征向量中添加噪声,防止身份信息泄露。

- 算法公平性:需解决不同种族、性别、年龄的识别偏差,非洲裔女性在早期系统中的错误率高达34%,通过平衡训练数据集(如UFR-23数据集)可将其降至5%以下。

相关问答FAQs

Q1:人脸识别在暗光环境下的准确率如何保证?

A:暗光环境下主要依赖红外传感器与深度学习算法的结合,红外摄像头捕捉不可见光下的面部热辐射特征,生成红外图像;通过低光增强算法(如Retinex)处理可见光图像,恢复细节特征,双模态数据输入至融合网络(如Siamese Network),联合优化特征提取,商汤科技的SenseTime系统在1lux极暗光条件下,准确率仍可达98%,活体检测误拒率低于2%。

Q2:人脸识别数据被泄露后,有哪些补救措施?

A:数据泄露后需采取“技术+管理”双维度补救:技术上,立即冻结受影响账户,强制重置密码;通过特征值重置(如重新采集人脸特征向量)使旧数据失效;引入区块链技术存储特征哈希值,确保数据不可篡改,管理上,启动数据泄露应急预案,向监管部门报备;采用隐私计算(如安全多方计算)对历史数据进行脱敏分析,追溯泄露源头,长期需建立动态更新机制,定期更换特征模板,降低数据滥用风险。