汽车人机交互技术原理是现代汽车智能化发展的核心,其本质是通过多模态感知、计算处理与反馈机制,实现人与车辆之间自然、高效的信息交换与控制,这一技术融合了传感器技术、计算机科学、人工智能、心理学等多个学科,旨在提升驾驶安全性、舒适性与智能化体验,以下从技术架构、核心模块、交互方式及发展趋势等方面展开详细阐述。

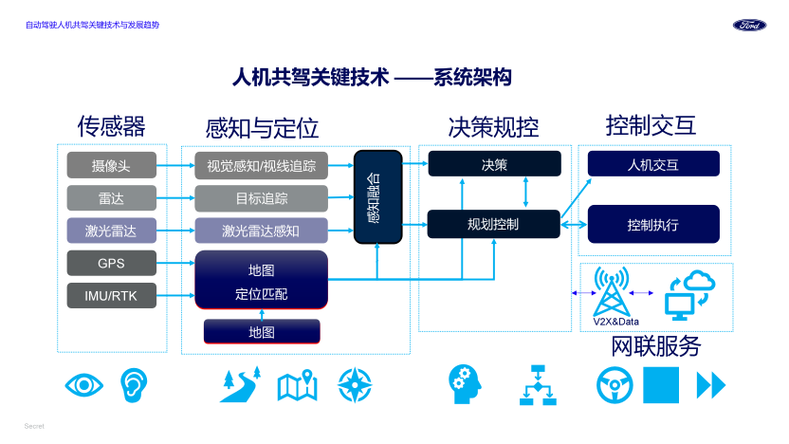

技术架构:分层感知与协同处理

汽车人机交互系统通常采用分层架构,自下而上分为感知层、处理层、执行层与应用层,各层级协同工作以完成交互任务。

-

感知层:负责采集用户指令与环境数据,是交互的“输入端”,通过多种传感器捕捉人类行为(如语音、手势、眼动)和车辆状态(如车速、导航信息、空调参数),形成原始数据流,麦克风阵列采集语音指令,摄像头捕捉手部动作,方向盘上的电容传感器监测握力变化,GPS模块提供实时位置数据。

-

处理层:作为系统“大脑”,对感知层数据进行融合分析与决策,基于嵌入式计算平台(如高通骁龙座舱芯片、NVIDIA Orin芯片),通过算法模型(如深度学习、自然语言处理)解析用户意图,同时结合车辆状态与驾驶场景(如高速拥堵、城市拥堵)生成响应策略,当语音指令为“调高空调温度”时,系统需先识别语义,再结合当前车内温度、环境温度及用户历史习惯,确定目标温度值。

-

执行层:将处理层的决策转化为具体动作,是交互的“输出端”,通过车载显示屏、HUD(抬头显示)、扬声器、触控反馈模块等设备向用户反馈信息,同时控制车辆执行机构(如空调电机、车窗控制器、自动驾驶系统)实现功能操作,语音指令执行后,空调电机自动调节出风口温度,同时屏幕显示温度变化动画。

(图片来源网络,侵删)

(图片来源网络,侵删) -

应用层:面向具体场景的交互功能实现,包括导航控制、娱乐系统调节、车辆设置、自动驾驶辅助等,该层需根据用户画像(如新手司机、专业驾驶员)与场景需求(如日常通勤、长途旅行)动态优化交互逻辑,例如在长途驾驶中优先推荐语音交互以减少分心。

核心模块:多模态交互的关键技术

汽车人机交互的核心在于多模态技术的融合,通过不同交互方式的互补与冗余,提升交互的鲁棒性与自然度。

语音交互:自然语言处理与声学技术

语音交互是目前最成熟的交互方式,其原理基于“语音识别-语义理解-指令执行”的流程。

- 语音识别:通过麦克风阵列采集声音信号,采用信号处理算法(如波束成形技术)消除车内噪声(如发动机轰鸣、风噪),再利用深度学习模型(如CNN、Transformer)将语音信号转化为文本,思必驰的DUI车载语音系统支持远场识别,在120km/h车速下仍可准确识别5米内的语音指令。

- 语义理解:基于自然语言处理(NLP)技术,结合上下文语境与用户习惯解析文本意图,通过知识图谱与意图槽位填充(如“导航到[地点]”中“地点”为槽位),解决口语化表达(如“我想去公司”对应“导航到公司地址”)的歧义问题。

- 语音合成:采用拼接合成或参数合成技术,将文本转换为自然语音,并通过车内音响系统播放,部分系统支持个性化语音定制(如音色、语速),提升用户体验。

视觉交互:计算机视觉与手势识别

视觉交互通过摄像头捕捉用户视觉行为,实现“看-懂-反馈”的闭环。

- 手势识别:基于RGB摄像头或3D传感器(如结构光、ToF),通过计算机视觉算法(如MediaPipe、OpenPose)提取手部关键点,识别预设手势(如旋转调节音量、左右滑动切换歌曲),宝马iDrive系统支持“抓取-滑动”手势控制中控屏,减少触屏操作。

- 眼动追踪:通过红外摄像头捕捉眼球运动,结合瞳孔位置与注视点判断用户注意力分布,当驾驶员视线偏离道路超过2秒时,系统可触发疲劳驾驶预警;在自动驾驶模式下,眼动数据可用于预测乘客下一步操作意图(如观察中控屏后调节座椅)。

- 表情识别:通过面部微表情分析用户情绪,例如检测到焦虑表情时自动调节车内氛围灯亮度或播放舒缓音乐,提升情感化交互体验。

触觉交互:物理反馈与多模态融合

触觉交互通过力、振动、温度等触觉信号传递信息,增强交互的沉浸感与准确性。

- 触控反馈:电容屏或电阻屏在接收到操作时,通过压电陶瓷产生振动反馈,模拟物理按键的“点击感”,提升触控操作的手感,特斯拉中控屏的触控反馈可让用户确认操作是否成功。

- 力反馈:在方向盘、换挡杆等部件集成力反馈电机,根据驾驶状态施加阻力或助力,自动驾驶模式下,方向盘可自动轻微转动提示路况变化;紧急制动时,方向盘振动提醒驾驶员接管。

- 多模态融合:当单一交互方式失效时(如嘈杂环境语音识别失败),系统自动切换至手势或触控交互,并通过屏幕提示“请使用手势调节音量”,实现交互方式的平滑过渡。

交互方式:从单一模态到多模态融合

汽车人机交互方式经历了从机械按键、触控屏到多模态融合的演进,当前主流技术包括以下几类:

| 交互方式 | 技术原理 | 应用场景 | 优势 | 局限性 |

|---|---|---|---|---|

| 语音交互 | 声学信号采集→噪声抑制→语音识别→语义理解→指令执行 | 导航控制、娱乐系统调节、电话拨打 | 解放双手双眼,适合驾驶场景 | 噪声环境下识别率下降,复杂指令理解有限 |

| 手势交互 | 摄像头捕捉手部动作→关键点提取→手势匹配→指令执行 | 空调调节、音量控制、切换歌曲 | 无接触,避免交叉感染 | 需特定手势,强光环境下识别率低 |

| 触控交互 | 电容屏感知手指位置→电阻变化→坐标计算→指令执行 | 车辆设置、导航输入、多媒体控制 | 直观易用,支持复杂操作 | 需视觉注意力,驾驶中分心风险高 |

| 眼动追踪 | 红外摄像头捕捉眼球运动→瞳孔定位→注视点分析→意图推断 | 疲劳预警、注意力监测、自动驾驶控制权交接 | 非接触,实时反映用户状态 | 需校准,隐私争议较大 |

| 生物识别 | 指纹/人脸/虹膜识别→特征匹配→身份验证→个性化设置 | 车辆启动、座椅/后视镜记忆、支付授权 | 高安全性,支持个性化交互 | 识别速度受环境影响,成本较高 |

发展趋势:智能化与场景化深度融合

未来汽车人机交互技术将向更自然、更智能、更安全的方向发展,核心趋势包括:

- 情感化交互:通过多模态传感器(语音、表情、生理信号)分析用户情绪状态,主动提供个性化服务,例如检测到驾驶员紧张时自动开启香氛与舒缓音乐。

- 跨设备无缝衔接:基于5G/V2X技术实现车-手机-家居设备互联,例如用户上车前通过手机发送导航指令,车辆自动同步并规划路线;到家前通过车辆远程启动家中空调。

- 自动驾驶交互重构:随着L3级以上自动驾驶普及,人机交互从“驾驶控制”转向“场景服务”,例如后排乘客可通过语音控制车内娱乐系统,驾驶员通过HUD接收实时路况与预警信息。

- 边缘计算与AI赋能:车载计算平台向边缘计算迁移,降低云端依赖,提升实时性;AI大模型(如GPT、BERT)增强语义理解能力,支持更复杂的自然语言交互(如“找一条避开拥堵且风景好的路线”)。

相关问答FAQs

Q1:汽车语音交互在嘈杂环境下如何提升识别准确率?

A:提升嘈杂环境下的语音识别准确率需从“端-边-云”三方面优化:端侧采用麦克风阵列与波束成形技术聚焦人声,结合深度学习噪声抑制算法消除背景噪声;边侧通过车载芯片实时处理语音数据,降低延迟;云侧利用大规模数据训练声学模型,针对特定场景(如高速、隧道)优化识别算法,多模态融合(如语音+手势)可在语音识别失败时切换交互方式,确保功能可用性。

Q2:手势交互在驾驶中是否存在安全隐患?如何规避?

A:手势交互若设计不当可能存在安全隐患,例如复杂手势或长时间抬手操作会增加驾驶分心风险,规避措施包括:①简化手势逻辑,采用直观、易操作的动作(如“挥手”接听电话、“捏合”调节音量);②限制交互场景,仅在车辆低速或自动驾驶状态下启用复杂手势;③结合视觉反馈,屏幕实时显示手势识别结果,避免误操作;④通过眼动追踪监测驾驶员注意力,若视线偏离道路则临时禁用手势交互。