智能视频分析技术的诞生与发展离不开数字视频技术、人工智能算法和算力支撑的协同演进,20世纪90年代以前,视频监控主要依赖模拟信号传输和人工值守,存储采用磁带介质,检索效率低下,视频内容的价值难以被有效挖掘,随着90年代末数字视频压缩标准(如MPEG-2、MPEG-4)的成熟,摄像机开始数字化录制,硬盘存储逐渐取代磁带,为视频结构化处理奠定了基础,但此时仍以人工回看分析为主,智能化程度几乎为零。

21世纪初是智能视频分析技术的萌芽期,计算机视觉领域的特征提取算法(如SIFT、HOG)逐渐成熟,2000年前后,学者们尝试将背景建模、运动检测等基础算法应用于视频监控,实现简单的运动目标检测(如Vibe算法、混合高斯模型)和场景变化分析,此时的系统受限于算力和算法精度,仅能在特定场景下实现像素级运动区域分割,无法区分目标类型(如人、车、动物),且易受光照、天气干扰,实际应用价值有限。

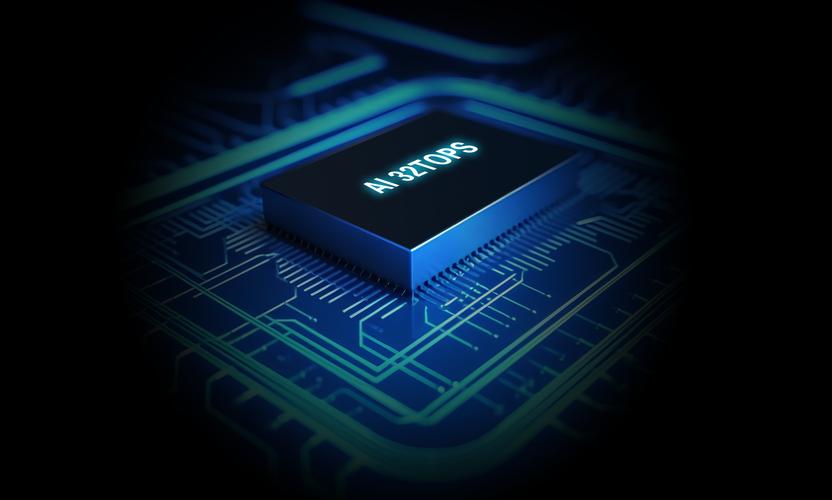

2010年后,深度学习技术的突破推动智能视频分析进入快速发展阶段,2012年AlexNet在ImageNet竞赛中取得突破性胜利,证明卷积神经网络(CNN)在图像特征提取上的优越性,随后YOLO、Faster R-CNN等目标检测算法的出现,实现了从“检测”到“识别”的跨越,2025年后,Transformer架构在视觉任务中的应用(如ViT、Swin Transformer)进一步提升了模型对长序列视频的理解能力,使行为识别(如打架、跌倒、徘徊)、事件检测(如人群聚集、车辆违停)等复杂场景分析成为可能,GPU、TPU等专用硬件算力的提升,以及边缘计算技术的发展,使得实时视频分析(如25帧/秒的目标跟踪)在边缘端部署成为现实,解决了云端传输的延迟和带宽瓶颈。

当前,智能视频分析技术已形成“感知-认知-决策”的完整技术链条,在感知层,通过目标检测、分割、跟踪算法实现视频内容的结构化提取(如目标类型、位置、轨迹、属性);在认知层,结合时序建模(如LSTM、3D-CNN)和知识图谱技术,实现行为理解、事件关联和异常检测;在决策层,通过与业务系统(如安防、交通、零售)的联动,自动触发预警、统计或控制指令,技术应用的广度也从安防领域扩展到智慧城市(交通流量监测、违章抓拍)、工业生产(设备缺陷检测、安全规范遵守)、零售商业(顾客动线分析、货架商品监控)、医疗健康(患者行为监测、跌倒预警)等多个场景,成为数字化转型的核心支撑技术之一。

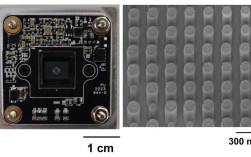

从技术架构看,智能视频分析系统通常分为前端智能和后端云端两种部署模式,前端智能将分析算法集成于摄像机或边缘设备中,实现实时本地处理,降低传输压力,适用于对实时性要求高的场景(如实时入侵报警);后端云端则通过视频云平台集中处理海量视频数据,利用分布式算力进行复杂模型训练和跨时空数据关联分析,适用于大规模数据挖掘(如城市级交通态势研判),两种模式通过“边缘-云端协同”架构实现优势互补,例如前端完成目标检测和跟踪,云端进行行为分析和数据可视化。

技术发展过程中,数据标注、模型轻量化、跨场景泛化能力等关键问题始终是研究热点,高质量标注数据是深度学习模型训练的基础,但人工标注成本高、效率低,半监督学习(如FixMatch)、自监督学习(如SimCLR)等无监督标注技术逐渐成为重要方向;模型轻量化通过知识蒸馏、网络剪枝、量化压缩等技术,将大型模型(如ResNet-50)压缩至适合边缘端部署的尺寸(如MobileNet级别),在保持精度的同时降低算力消耗;跨场景泛化则通过域自适应(Domain Adaptation)、元学习(Meta-Learning)等方法,解决模型在训练场景与实际场景差异导致的性能下降问题,提升技术的普适性。

智能视频分析技术将向多模态融合、实时性与鲁棒性提升、可解释性增强等方向发展,多模态融合结合视频、音频、文本、传感器数据(如温度、湿度),通过跨模态注意力机制提升复杂场景的理解能力(如火灾检测中融合烟雾视觉特征和温度异常数据);实时性与鲁棒性提升依赖于更高效的算法架构(如动态神经网络)和硬件加速(如NPU、存算一体芯片),以应对极端环境(如雨雾、夜间)和复杂遮挡场景;可解释性则通过可视化特征图、注意力权重分析等技术,解决深度学习“黑箱”问题,增强用户对分析结果的信任度,推动技术在金融、医疗等高合规要求领域的落地应用。

| 技术发展阶段 | 核心技术特征 | 代表性算法/应用 | 主要局限性 |

|---|---|---|---|

| 模拟视频时期(20世纪90年代前) | 模拟信号传输、磁带存储、人工值守 | CCTV监控系统 | 无法检索、无智能分析功能 |

| 数字化初期(2000-2010年) | 数字压缩、硬盘存储、基础运动检测 | 背景建模、帧间差分、Vibe算法 | 精度低、易受干扰、无法识别目标类型 |

| 深度学习发展期(2010-2025年) | CNN目标检测、行为识别、边缘计算 | YOLO、Faster R-CNN、LSTM行为分析 | 算力需求高、小目标检测效果差 |

| 多模态融合期(2025年至今) | Transformer视觉模型、跨模态学习、知识图谱 | Swin Transformer、CLIP多模态对齐、事件知识图谱 | 数据依赖性强、可解释性不足、跨场景泛化能力有限 |

相关问答FAQs:

Q1:智能视频分析技术与传统视频监控的主要区别是什么?

A1:传统视频监控以“录制-回放”为核心,依赖人工查看视频内容,实时性差、效率低,且无法主动发现异常;智能视频分析技术通过算法自动提取视频中的结构化信息(如目标类型、行为、事件),实现实时监测、智能预警和数据分析,将视频从“事后追溯”转变为“事中干预”和“事前预测”,大幅提升监控系统的自动化和价值挖掘能力。

Q2:智能视频分析技术在边缘端部署面临哪些挑战?

A2:边缘端部署主要面临三方面挑战:一是算力限制,边缘设备(如智能摄像头)的算力和存储空间有限,难以直接运行大型深度学习模型;二是功耗约束,嵌入式设备需低功耗运行,高精度模型的高计算量可能导致设备过热或续航不足;三是环境适应性,边缘场景复杂多变(如光照变化、天气干扰),模型需具备较强的鲁棒性以应对极端条件,解决这些问题需要通过模型轻量化(如剪枝、量化)、硬件加速(如NPU集成)以及自适应算法优化等技术实现。