- 什么是SLAM? (定义与核心问题)

- 为什么SLAM如此重要? (它的价值所在)

- SLAM是如何工作的? (核心组成部分与工作流程)

- SLAM的关键技术挑战 (为什么它很难)

- 主要的SLAM算法分类 (从传统到现代)

- SLAM的应用领域 (它能用在什么地方)

- 未来的发展趋势

什么是SLAM? (定义与核心问题)

SLAM 是 Simultaneous Localization and Mapping 的缩写,中文翻译为 “同时定位与地图构建”。

SLAM要解决的问题是:一个机器人(或任何移动设备)在一个未知的环境中移动,如何一边构建出这个环境的地图,一边确定自己在地图中的位置?

这就像一个刚搬到陌生城市的人,没有GPS,也没有地图,他需要:

- 定位:通过观察周围的地标(如商店、建筑)来判断自己当前在哪里。

- 建图:将这些地标记录下来,形成一张心理地图,知道哪些路是通的,哪些是死胡同。

SLAM就是让机器人用传感器(而不是眼睛)完成这个过程,这是一个典型的“鸡生蛋还是蛋生鸡”的问题:

- 为了定位,你需要一张地图。

- 为了建图,你需要知道自己的位置。

SLAM的精髓就在于,它通过传感器数据,将这两个问题耦合在一起,实时地解决它们。

为什么SLAM如此重要?

SLAM是机器人实现真正自主移动和智能交互的基石,没有SLAM,机器人就相当于一个“盲人”,无法理解自己所处的环境,更谈不上自主导航、避障、完成任务。

- 自主导航:让扫地机器人、送餐机器人、自动驾驶汽车能在室内外自由穿梭。

- 环境感知:让机器人理解三维空间的结构,用于AR/VR应用、工业检测等。

- 任务执行:机器人需要知道自己的位置和周围环境,才能完成抓取、装配、救援等复杂任务。

可以说,SLAM是机器人从“自动化”走向“智能化”的关键一步。

SLAM是如何工作的? (核心组成部分与工作流程)

一个典型的SLAM系统主要由以下几个部分组成,并按照一个循环流程工作:

核心组成部分:

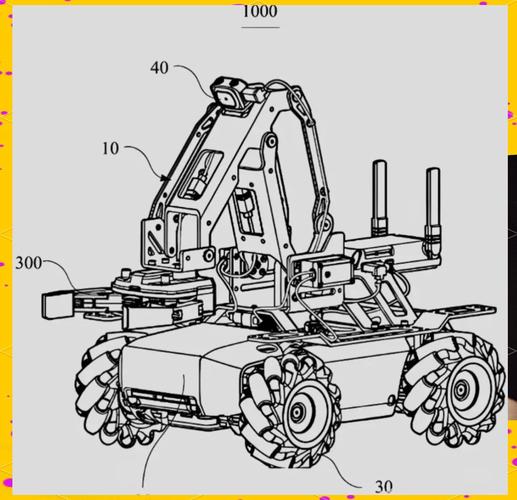

- 机器人平台:可以是轮式机器人、无人机、机械臂、手机等。

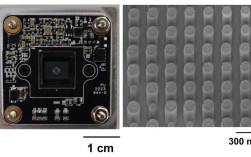

- 传感器:SLAM的“眼睛”和“耳朵”。

- 内部传感器:测量机器人自身的运动状态,如里程计(编码器、IMU惯性测量单元),它们告诉机器人“我认为我向前走了10厘米,向左转了30度”,但这类传感器存在累积误差,时间长了会严重偏离真实位置。

- 外部传感器:测量外部环境,用于感知和定位。

- 激光雷达:通过发射激光束并接收反射信号,精确测量周围物体的距离,生成高精度的点云图,是目前最主流、最可靠的传感器之一。

- 摄像头:通过图像和视频来感知环境,成本低,信息丰富(颜色、纹理),但处理复杂,基于视觉的SLAM(V-SLAM)是当前研究热点。

- 其他:深度摄像头(如Kinect)、毫米波雷达、超声波等。

- 前端:也叫数据关联 或回环检测 模块。

- 任务:处理传感器数据,找到不同时刻观测到的相同特征点(如一个角点、一条边缘)。

- 作用:判断机器人是否回到了曾经到过的地方(回环检测),从而修正累积误差,让地图更一致。

- 后端:也叫优化 模块。

- 任务:这是SLAM的“大脑”,它收集前端提供的所有信息(机器人运动、观测数据、回环信息),通过优化算法(如图优化)来计算出一组最可能的状态(机器人位姿和地图特征点)。

- 作用:最小化整个系统(从开始到当前时刻)的误差,得到全局一致的最优解,著名的算法有扩展卡尔曼滤波 和图优化。

- 回环检测:一个关键的子模块,通常属于前端。

- 任务:判断当前场景是否与历史某时刻的场景相同。

- 方法:对于视觉SLAM,常用词袋模型;对于激光SLAM,常用点云配准或扫描匹配。

- 作用:发现“圈”后,告诉后端“我们回到了这里!”,后端会利用这个信息进行全局优化,极大地修正了里程计的累积误差。

工作流程:

- 初始化:在起点处,通过几次观测初始化一个局部的地图和机器人的初始位姿。

- 预测:根据内部传感器(里程计)的数据,预测机器人下一步可能的位置和姿态,这会产生一个先验估计。

- 更新:外部传感器(激光/相机)获取新的环境观测数据,与预测位置上的地图进行比对(数据关联)。

- 优化:将新的观测数据、预测的误差以及可能发现的回环信息,全部送入后端优化器,后端计算出误差最小的最优解,更新机器人当前位姿和地图。

- 循环:机器人移动到新位置,重复 2 -> 3 -> 4 的过程,不断迭代,实现实时定位与建图。

SLAM的关键技术挑战

SLAM看似简单,但要实现鲁棒、实时、精确的系统,面临诸多挑战:

- 数据关联:在动态、重复、纹理贫乏的环境中,如何准确地将当前观测到的特征与历史地图中的特征匹配起来,是一个巨大的难题。

- 累积误差:内部传感器的误差会随时间累积,导致定位和地图越来越不准确。

- 动态环境:现实世界不是静止的,会有行人、车辆、移动的家具等,如何区分静态背景和动态物体,是动态SLAM的研究重点。

- 实时性与计算效率:尤其是在资源受限的移动设备(如无人机、手机)上,需要高效的算法才能保证实时运行。

- 尺度不确定性:单目相机SLAM存在尺度模糊问题,它不知道一个物体是“远且大”还是“近且小”。

- 传感器局限性:传感器有噪声、有盲区、有延迟,激光雷达在玻璃等透明表面表现不佳,相机在弱光或纹理重复环境下容易失效。

主要的SLAM算法分类

SLAM算法根据传感器类型和理论框架,可以分为几大类:

A. 基于传感器的分类

-

激光SLAM (Lidar SLAM)

- 代表:GMapping, Cartographer, LOAM (Lidar Odometry and Mapping)

- 特点:精度高,鲁棒性强,生成的地图(点云)直接可用,但激光雷达成本较高,且在室外大阳光下性能可能受影响。

- 核心技术:扫描匹配、粒子滤波、图优化。

-

视觉SLAM (Visual SLAM, V-SLAM)

- 代表:ORB-SLAM, PTAM, SVO (Semi-Direct Visual Odometry)

- 特点:成本低,信息丰富(提供RGB-D数据),在纹理丰富的室内效果很好,但对光照变化、运动模糊、纹理贫乏环境敏感。

- 核心技术:特征提取与匹配(如ORB, SIFT)、对极几何、PnP(Perspective-n-Point)求解位姿。

-

多传感器融合SLAM

- 代表:将激光、视觉、IMU、轮速计等数据融合。

- 特点:取长补短,提高系统的鲁棒性和精度,用IMU提供高频运动预测,用激光/视觉进行修正,这是目前工业界和学术界的主流方向。

B. 基于后端优化框架的分类

-

基于滤波的方法

- 代表:EKF (Extended Kalman Filter), Particle Filter

- 特点:将SLAM问题看作一个状态估计问题,EKF是经典方法,但只处理线性化后的高斯噪声,计算复杂度高,难以处理大规模地图,粒子滤波适用于非高斯噪声,但计算量巨大。

-

基于图优化的方法

- 代表:g2o, Ceres Solver, iSAM

- 特点:将SLAM问题构建成一个图,图中节点 代表机器人位姿或地图特征点,边 代表它们之间的约束(运动约束或观测约束),通过调整节点位置来最小化所有边的误差,这种方法非常适合处理大规模问题,是当前的主流框架。

SLAM的应用领域

SLAM技术已经渗透到我们生活的方方面面:

-

消费级领域:

- 扫地机器人:如iRobot, Roomba,通过激光SLAM或视觉SLAM进行导航和建图,规划清扫路径。

- 智能手机:AR应用(如Pokemon GO)利用V-SLAM将虚拟物体叠加到真实世界。

- VR/AR设备:在虚拟空间中实现头部和手部定位,以及与虚拟环境的交互。

-

工业与商业领域:

- 仓储物流机器人:在大型仓库中自主导航、搬运货物。

- 自动驾驶:是自动驾驶汽车的核心技术之一,用于高精地图构建和实时定位。

- 无人机:进行自主飞行、航拍、地形测绘、电力巡检。

- 机器人手术:帮助医生精确导航手术器械。

-

专业与科研领域:

- 灾难救援:派遣机器人进入危险环境,绘制地图并寻找幸存者。

- 考古与勘探:对古墓、洞穴进行三维建模。

- 建筑与测绘:快速生成建筑或工地的三维模型。

未来的发展趋势

SLAM技术仍在不断发展,未来的趋势主要集中在:

- 深度学习与SLAM的结合:利用深度学习进行更鲁棒的特征提取、场景理解、动态物体分割,甚至直接从原始数据中学习位姿(End-to-End SLAM)。

- 4D SLAM (三维+时间):构建不仅包含空间信息,还包含时间动态信息的地图,更好地理解动态环境。

- 语义SLAM (Semantic SLAM):将地图从几何层面提升到语义层面,机器人不仅能建出点云图,还能知道“这是一张桌子”、“那是一把椅子”,实现更高层次的智能交互。

- 大规模SLAM与云端SLAM:将SLAM的计算部分放到云端,处理城市级甚至更大范围的地图构建。

- 多机器人SLAM:多个机器人协同工作,共享地图和定位信息,提高建图效率和覆盖范围。

SLAM是赋予机器人“感知”和“认知”环境能力的核心技术,它通过巧妙地融合多种传感器数据,实时地解决了“我在哪”和“环境什么样”这两个根本问题,从扫地机器人到自动驾驶汽车,SLAM正在深刻地改变着我们的生活和工作方式,并且随着人工智能和传感器技术的进步,其能力将变得更加智能和强大。