这是一个非常有趣且应用广泛的话题,人脸识别表情的过程,就是计算机通过分析人脸图像或视频中的关键特征点,来判断这个人当前处于哪种情绪状态。

下面我将从核心原理、技术流程、主要挑战和应用场景四个方面进行详细说明。

核心原理:从“看到脸”到“读懂心”

计算机不像人类那样能直观地“感受”到情绪,它需要将表情这个抽象概念,转化为可以量化的数据,其核心原理可以概括为:

- 定位面部关键点:计算机需要在图像中找到人脸,并精确定位出构成表情的“肌肉”附着点,眉毛、眼睛、鼻子、嘴巴、脸颊轮廓等,这些点通常有几十个到上百个不等。

- 提取面部动作单元:计算机分析这些关键点相对于中性表情(面无表情)时发生的位移、旋转和形变,每一种特定的面部肌肉运动组合,被称为一个“动作单元”(Action Unit, AU)。

- AU12代表“嘴角上提”(微笑的核心动作),AU4代表“眉毛内角上提”(惊讶时的眉毛动作)。

- 一个复杂的表情,如“开心”,可以分解为 AU12(嘴角上提)、AU6(脸颊上提)和 AU25(嘴唇分开)的组合。

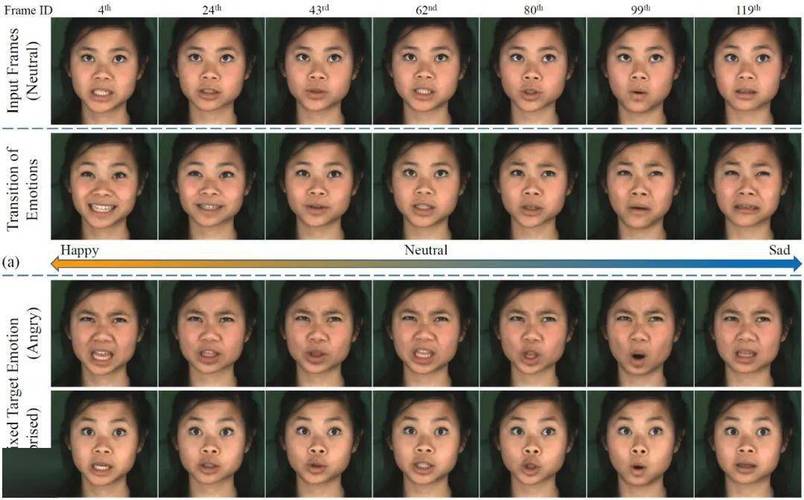

- 映射到情绪标签:系统将检测到的AU组合与预设的基本情绪模型进行匹配,从而得出一个或多个情绪标签,如“高兴”、“悲伤”、“愤怒”、“惊讶”、“恐惧”、“厌恶”和“中性”(这是心理学上最经典的“情绪六维模型”)。

技术流程:一步步如何实现

一个典型的人脸表情识别系统通常包含以下几个步骤:

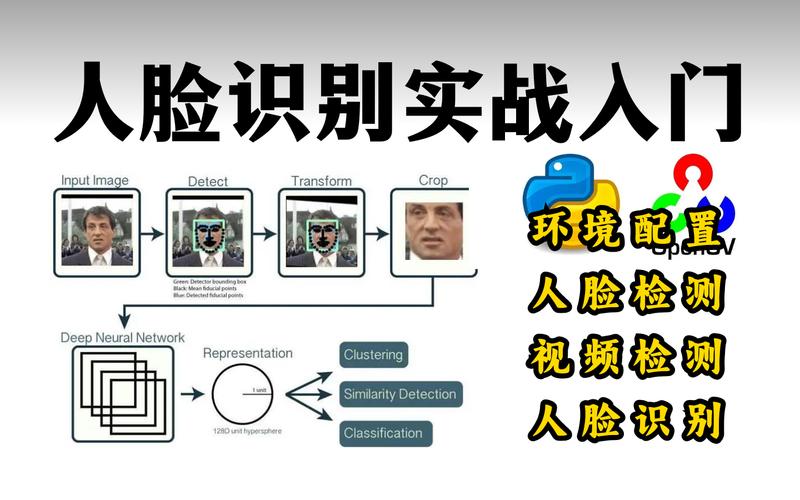

第一步:人脸检测与对齐

- 人脸检测:从一张复杂的图片或视频中,准确地框出人脸的位置,这通常使用像Haar特征、HOG(方向梯度直方图)或更先进的深度学习模型(如MTCNN, YOLO)来完成。

- 人脸对齐:检测到人脸后,需要进行对齐,以消除头部姿态(旋转、倾斜)带来的干扰,通过对齐,确保人脸始终处于一个标准的姿态(如正面、双眼水平),这样后续的特征提取才更准确,这个过程依赖于刚才提到的面部关键点检测。

第二步:特征提取

这是最核心的一步,目的是从对齐后的人脸图像中提取出能够代表表情信息的特征,主流方法有两种:

-

传统方法:

- 几何特征:直接利用面部关键点的位置和形状信息,计算两个嘴角之间的距离(嘴角宽度)、眉骨与眼睛之间的距离等,这种方法直观,但对姿态和光照比较敏感。

- 外观特征:分析人脸皮肤区域的纹理、颜色和像素强度变化,微笑时脸颊会鼓起,像素强度会发生变化;悲伤时嘴角下垂,皮肤纹理会拉伸,常用算法包括局部二值模式、方向梯度直方图等。

-

深度学习方法(当前主流):

- 卷积神经网络是目前最强大的特征提取器,它能够自动从原始像素中学习到层次化的特征,从低级的边缘、纹理,到高级的鼻子、眼睛、嘴巴的形状,再到组合这些形状形成的特定表情模式。

- 常用的CNN架构有VGG, ResNet, Inception等,这些模型在大型人脸表情数据集(如FER-2025, CK+)上经过训练后,拥有极强的特征提取能力。

第三步:表情分类

在提取出表情特征后,需要将这些特征输入到一个分类器中,最终输出表情的类别。

- 分类器:

- 传统方法:支持向量机、决策树、Adaboost等。

- 深度学习方法:通常在CNN的末端直接接上一个全连接层和Softmax激活函数,形成一个端到端的分类网络,网络会直接输出一个概率分布,表示当前图像属于“高兴”、“悲伤”等各个类别的可能性。

第四步:结果输出与后处理

系统会输出最可能的表情类别,并给出一个置信度分数,在视频流中,还会加入时间平滑处理,以避免表情在几帧之间频繁跳动,使结果更符合人类的感知习惯。

主要挑战与局限性

尽管技术发展迅速,但人脸表情识别仍面临诸多挑战:

- 个体差异:不同的人表达同一种情绪时,面部动作的强度和方式可能差异巨大,有些人不苟言笑,有些人则表情丰富,模型需要具备足够的泛化能力来适应这些差异。

- 文化差异:某些表情的含义可能因文化背景而异,微笑在不同文化中可能代表高兴、尴尬、甚至是礼貌。

- 复合情绪:现实中,人们常常同时体验多种情绪(如“惊喜交加”),或者用表情掩饰真实情绪(如“强颜欢笑”),这给简单的分类带来了困难。

- 外部干扰:

- 光照:强光、阴影会严重影响图像质量,干扰特征提取。

- 姿态:侧脸、仰头、低头等非正面姿态会遮挡部分面部特征,增加识别难度。

- 遮挡物:口罩、眼镜、帽子、头发等会严重遮挡嘴巴、鼻子等关键表情区域。

- 分辨率:低分辨率或模糊的人脸图像难以提取有效特征。

- 动态性:表情是一个动态变化的过程,静态图片只能捕捉到某一瞬间的状态,可能会丢失表情的起始和演变过程,而这些过程本身也包含着丰富的信息。

主要应用场景

人脸表情识别技术已经渗透到我们生活的方方面面:

-

人机交互:

- 情感计算:让机器人、虚拟助手、智能汽车能够感知用户的情绪状态,从而做出更智能、更人性化的反应,当检测到驾驶员疲劳或愤怒时,系统发出警报。

- 游戏与娱乐:游戏中根据玩家的表情调整剧情或难度;VR/AR应用中,让虚拟角色对用户的表情做出实时反馈。

-

市场与广告分析:

通过分析观众在观看广告或产品时的表情(如“感兴趣”、“惊讶”、“厌恶”),来评估广告效果和产品吸引力,为营销决策提供数据支持。

-

教育与在线学习:

在线教育平台通过分析学生的表情,判断其是否对课程内容感到困惑、无聊或专注,从而帮助老师调整教学策略。

-

医疗健康:

- 辅助诊断:帮助自闭症或帕金森症患者进行康复训练,通过识别他们微弱的表情变化来评估治疗效果。

- 精神健康监测:长期跟踪患者的情绪波动,为心理医生提供客观参考数据。

-

安防与公共安全:

在机场、车站等公共场所,通过分析人群的异常表情(如极度恐慌、愤怒)来辅助预警潜在的安全威胁。

-

客户服务:

在呼叫中心,通过分析客服人员和客户的表情,评估服务质量,发现潜在的服务冲突。

人脸表情识别技术是一个典型的“人工智能+心理学”交叉领域,它通过计算机视觉和机器学习算法,将人类复杂的面部表情转化为可分析的数据,虽然目前仍面临诸多挑战,但随着深度学习等技术的不断进步,其准确性和鲁棒性在持续提升,应用前景也愈发广阔,正在深刻地改变着我们与机器、与环境的交互方式。