增强现实技术(Augmented Reality,AR)的光学原理是实现虚拟信息与现实世界融合的核心基础,其通过精密的光学系统设计,将计算机生成的数字内容(如图像、文字、3D模型等)精准叠加到用户的真实视野中,这一过程涉及光的传播、调制、显示及人眼感知等多个物理层面的协同作用,具体可分为光学显示原理、光学透视原理以及光学感知与校准原理三大模块。

光学显示原理:虚拟内容的生成与投射

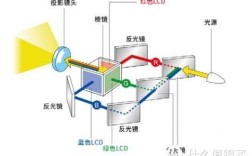

AR系统的显示端是虚拟信息的“出口”,其核心任务是将数字信号转化为可见光,并使其能够与真实环境光线共存,目前主流的AR显示技术基于微显示芯片(如Micro-OLED、MicroLED、LCoS等)和光学引擎,通过特定的光路设计将图像投射至人眼。

以主流的近眼显示(Near-Eye Display,NED)技术为例,微显示芯片生成的图像首先经过光学调制,再由透镜组或光波导(Optical Waveguide)进行扩束和准直,最终形成平行光或近似平行光进入人眼,这一过程中,关键的光学元件包括:

- 成像透镜组:负责将微显示芯片的小尺寸图像放大至适合人眼观察的视场角(Field of View,FOV),同时确保图像的清晰度和畸变控制。

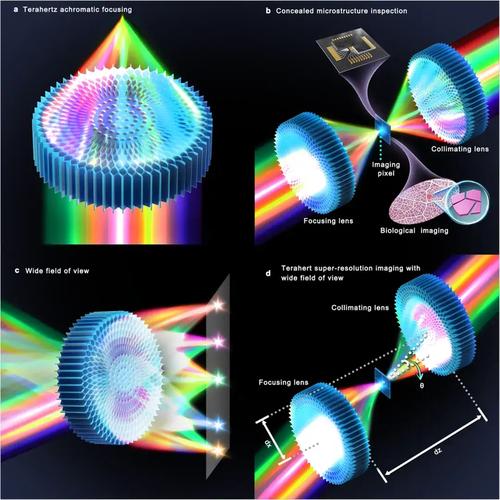

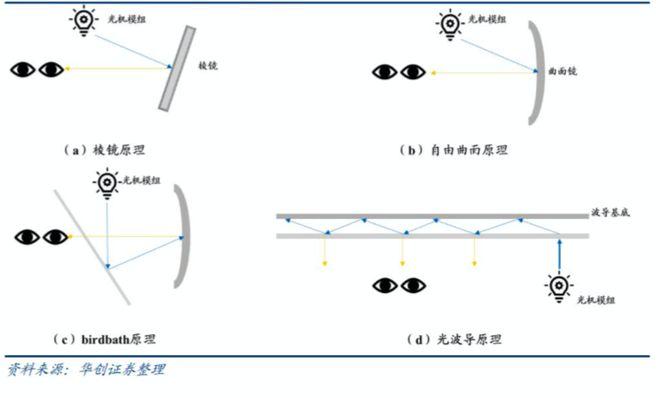

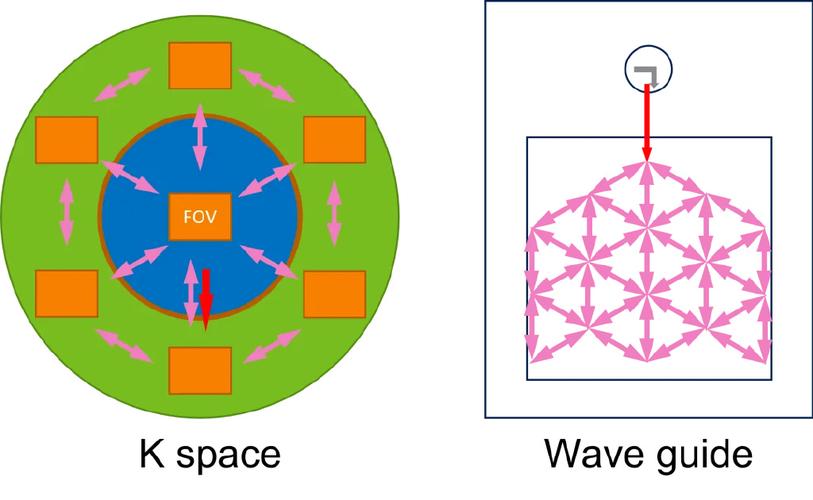

- 光波导:在AR眼镜等轻量化设备中,光波导通过全内反射(Total Internal Reflection,TIR)原理,将显示模组生成的光线在透明介质(如玻璃或树脂)中多次反射并耦合至人眼瞳孔,既避免了传统透镜的 bulky 体积,又实现了大角度的光线扩散,衍射光波导利用光栅结构将光线分束,反射光波导则通过反射面实现光路折叠,两者均需严格控制光栅周期、刻蚀深度等参数,以减少光能损失和杂散光干扰。

为了解决虚拟内容与现实环境的亮度匹配问题,AR显示系统需具备高亮度(gt;1000 cd/m²)和高对比度特性,同时通过动态调节背光或环境光传感器,确保数字信息在不同光照条件下均清晰可见。

光学透视原理:虚实光线的融合与叠加

AR的核心目标是让用户“看到”叠加在现实场景中的虚拟内容,这需要光学系统既能透射真实环境光,又能高效反射或投射虚拟图像,实现两者的无缝融合,根据虚实光线融合方式的不同,光学透视原理可分为光学透视式(Optical See-Through,OST)和视频透视式(Video See-Through,VST)两大类。

光学透视式(OST)

OST系统通过半反半透镜(Beam Splitter)或部分反射镜(Partial Reflector)直接将虚拟图像与现实场景光线合并,其光路设计为:真实环境光线透过半反半透镜进入人眼,而微显示设备生成的虚拟图像则经反射后进入同一光路,最终两者在人眼视网膜上叠加。

- 优势:延迟低、真实场景无畸变,适用于需要高精度的场景(如工业维修、医疗导航)。

- 挑战:需精确匹配虚拟图像的亮度、色温与真实环境,且半反半透镜的光能损失(通常50%以上)会导致真实场景亮度降低,需通过高亮度显示模组补偿。

视频透视式(VST)

VST系统通过摄像头捕捉真实场景图像,经计算机处理后与虚拟内容合成,最终将合成后的图像显示在近眼显示屏上,其光路本质是“先拍摄后显示”,虚实融合在数字域完成。

- 优势:灵活调节虚拟内容的透明度、颜色及叠加位置,且可通过图像处理算法增强真实场景(如边缘检测、光照补偿)。

- 挑战:存在摄像头延迟与显示延迟的叠加问题(通常需<20ms以避免眩晕),且需解决摄像头与显示屏之间的视差(Parallax)问题,避免虚拟内容与现实物体位置错位。

下表对比了两种透视技术的核心差异:

| 特性 | 光学透视式(OST) | 视频透视式(VST) |

|---|---|---|

| 虚实融合方式 | 光学直接叠加 | 数字域合成后显示 |

| 延迟 | 极低(仅光学传播延迟) | 较高(摄像头+处理+显示延迟) |

| 真实场景保真度 | 无畸变、高分辨率 | 依赖摄像头分辨率,可能存在畸变 |

| 环境适应性 | 受半反半透镜透光率限制,暗环境性能下降 | 可通过算法增强暗光场景,适应性更强 |

| 典型应用 | 工业维修、医疗导航 | 消费级AR游戏、社交娱乐 |

光学感知与校准原理:虚实对齐的关键

AR的“沉浸感”依赖于虚拟内容与现实物体的精准对齐,这需要光学系统实时感知用户头部姿态、环境空间位置及眼球运动,并通过动态调整光路参数实现“虚实同步”。

- 头部姿态追踪:通过惯性测量单元(IMU,包含加速度计、陀螺仪)和视觉SLAM(Simultaneous Localization and Mapping)技术,实时获取用户头部的位置和朝向数据,驱动虚拟视角同步更新,光学层面,需确保显示光路的光轴与头部姿态变化保持一致,避免因视轴偏移导致的图像漂移。

- 眼动追踪:通过红外摄像头和近红外光源照射眼球,捕捉瞳孔和角膜反射点,计算视线方向,这不仅用于交互(如虚拟按钮点击),还能动态调节AR显示的“聚焦深度”(通过可变焦透镜或光场显示技术),解决人眼调节与集合冲突(Vergence-Accommodation Conflict)导致的视觉疲劳问题。

- 空间校准:通过环境深度传感器(如LiDAR、结构光或ToF相机)获取场景三维点云数据,结合视觉算法识别平面(如地面、桌面)或物体轮廓,为虚拟内容提供“锚点”,确保其稳定附着在真实物体表面。

相关问答FAQs

Q1:AR眼镜的光波导技术为什么能实现轻薄设计?与传统透镜有何区别?

A:光波导利用全内反射原理,将显示模组生成的光线约束在透明介质(如玻璃基片)内部,通过入射光栅(In-coupler)将光线耦合进波导,再经过反射光栅(Out-coupler)多次分束并定向输出至人眼,这一过程中,光线在波导内传播路径较长,但无需传统透镜的复杂曲面堆叠,因此大幅减小了设备厚度,传统透镜则需要直接对图像进行放大和准直,体积与焦距成正比,难以满足近眼显示的轻量化需求。

Q2:光学透视式AR(OST)如何解决半反半透镜导致的亮度损失问题?

A:主要通过两种方式优化:一是采用高透光率的半反半透镜(如透过率>80%的介质膜片),但这会降低虚拟图像的亮度,需搭配高亮度微显示芯片(如MicroLED,亮度可达10000 cd/m²以上);二是使用偏振分光技术,通过偏振片分离环境光与虚拟图像的偏振态,减少光能交叉损失,例如环境光为垂直偏振,虚拟图像为水平偏振,两者在半反半透镜处互不干扰,从而提升整体光效。