- 核心概念:图像检测 vs. 目标跟踪

- 核心技术:目标检测

- 核心技术:目标跟踪

- 检测与跟踪的协同工作

- 主流应用领域

- 技术挑战与未来趋势

核心概念:图像检测 vs. 目标跟踪

可以做一个比喻:

- 目标检测:像是在一张静态照片中,用笔圈出所有你认识的人,并给每个人贴上标签(如“张三”、“李四”),它的任务是回答“在哪里?是什么?”。

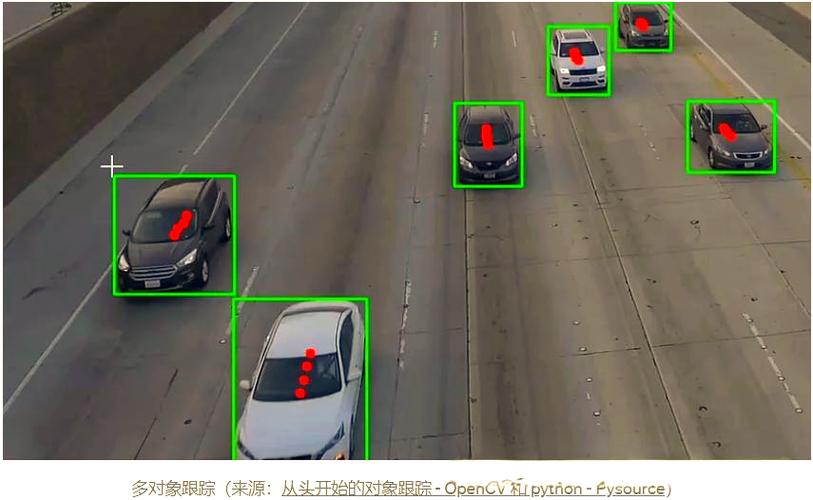

- 目标跟踪:像是在一段连续的视频中,持续地用笔圈出其中一个人,无论他走到哪里、是否被短暂遮挡,它的任务是回答“这个目标下一帧会去哪里?”。

目标检测

- 输入:一张静态图像。

- 输出:一个或多个边界框,每个边界框都对应一个类别标签和置信度分数。

- 关键问题:

- 定位:目标在图像中的精确位置(用边界框表示)。

- 分类:目标属于哪个预定义的类别(如人、车、狗)。

- 实例分割(更高级):不仅定位和分类,还要精确勾勒出目标的轮廓像素。

目标跟踪

- 输入:一段视频序列(第一帧需要检测,后续帧进行跟踪)。

- 输出:在每一帧图像中,为每个被跟踪的目标分配一个唯一的ID,并输出其新的位置。

- 关键问题:

- 初始化:通常在第一帧通过目标检测来确定要跟踪的目标。

- 状态估计:预测目标在下一帧可能出现的位置。

- 数据关联:将上一帧的目标与当前帧的检测框或特征点正确匹配起来。

- 鲁棒性:处理目标的形变、遮挡、光照变化、快速运动等问题。

核心技术:目标检测

目标检测技术的发展大致可以分为两个时代:传统方法和基于深度学习的方法。

A. 传统方法

这类方法通常将检测问题分解为两个步骤:候选区域生成 和 特征提取与分类。

-

候选区域生成:

- 目标:在图像中可能包含物体的区域,减少需要计算的区域数量。

- 代表算法:

- 滑动窗口:在不同尺度和比例的窗口上运行分类器,计算量大。

- 选择性搜索:通过图像分割、合并相似区域,生成约2000个高质量的候选区域,效率较高。

-

特征提取与分类:

(图片来源网络,侵删)

(图片来源网络,侵删)- 目标:对每个候选区域提取特征,并判断其是否为物体以及属于哪一类。

- 代表算法:

- HOG (方向梯度直方图):描述物体的形状信息。

- SVM (支持向量机):一个强大的分类器,常与HOG结合使用。

- DPM ( deformable part models ):将物体视为多个可变形部件的组合,能更好地处理姿态变化。

经典组合:HOG + SVM 或 DPM 是传统检测器的巅峰之作,但在复杂场景下表现有限。

B. 基于深度学习的方法(当前主流)

这类方法将特征提取和分类/回归整合在一个端到端的深度神经网络中,性能远超传统方法。

-

Two-Stage(两阶段)检测器:先生成候选区域,再对候选区域进行精细分类和位置回归,精度通常更高,但速度较慢。

- 代表算法:

- R-CNN系列:开山之作,奠定了两阶段检测器的基础。

- Fast R-CNN:引入RoI Pooling层,实现了端到端的训练,速度大幅提升。

- Faster R-CNN:提出了RPN (Region Proposal Network),将候选区域生成也放入网络中,实现了真正的端到端检测,是两阶段检测器的标杆。

- Mask R-CNN:在Faster R-CNN基础上增加了实例分割分支,可以同时完成检测和分割任务。

- 代表算法:

-

One-Stage(单阶段)检测器:直接在图像的不同位置和尺度上预测目标,省去了候选区域生成步骤,速度更快,但早期精度略低于两阶段方法。

(图片来源网络,侵删)

(图片来源网络,侵删)- 代表算法:

- YOLO (You Only Look Once) 系列:将图像划分为网格,每个网格直接预测边界框和类别,实现了极高的实时性,从YOLOv1到YOLOv8/v9,不断在速度和精度上取得突破。

- SSD (Single Shot MultiBox Detector):在多个不同尺度的特征图上进行预测,对不同大小的目标都有较好的检测效果。

- 代表算法:

-

Transformer-based 检测器:将自然语言处理领域的Transformer架构引入目标检测,利用其强大的全局建模能力。

- 代表算法:

- DETR (DEtection TRansformer):首次将Transformer用于检测,通过一个“集合预测”的思想,彻底摒弃了非极大值抑制等后处理操作,开创了检测的新范式。

- Swin Transformer:将Transformer设计成一个层次化结构,使其能够高效处理高分辨率的图像,成为当前SOTA(State-of-the-Art)检测器的常用骨干网络。

- 代表算法:

核心技术:目标跟踪

目标跟踪方法通常分为两大类:生成式方法 和 判别式方法,现代跟踪几乎都是判别式方法。

A. 生成式方法

- 思想:学习一个目标的外观模型,然后在下一帧中寻找与该模型最相似的图像区域。

- 缺点:对背景变化敏感,容易跟踪到与目标外观相似的背景区域。

B. 判别式方法(主流)

- 思想:同时学习目标和背景的模型,将跟踪问题看作一个二分类问题,区分目标区域和背景区域,这种方法鲁棒性更强。

现代判别式跟踪器主要分为两类:

-

相关滤波跟踪

- 思想:在傅里叶域高效地计算目标模板与图像所有区域的互相关响应,响应值最高的位置即为预测的目标位置。

- 优点:计算速度快,非常适合实时跟踪。

- 代表算法:

- KCF (Kernelized Correlation Filters)

- ECO (Efficient Convolution Operators)

- 缺点:训练样本单一,容易模型漂移。

-

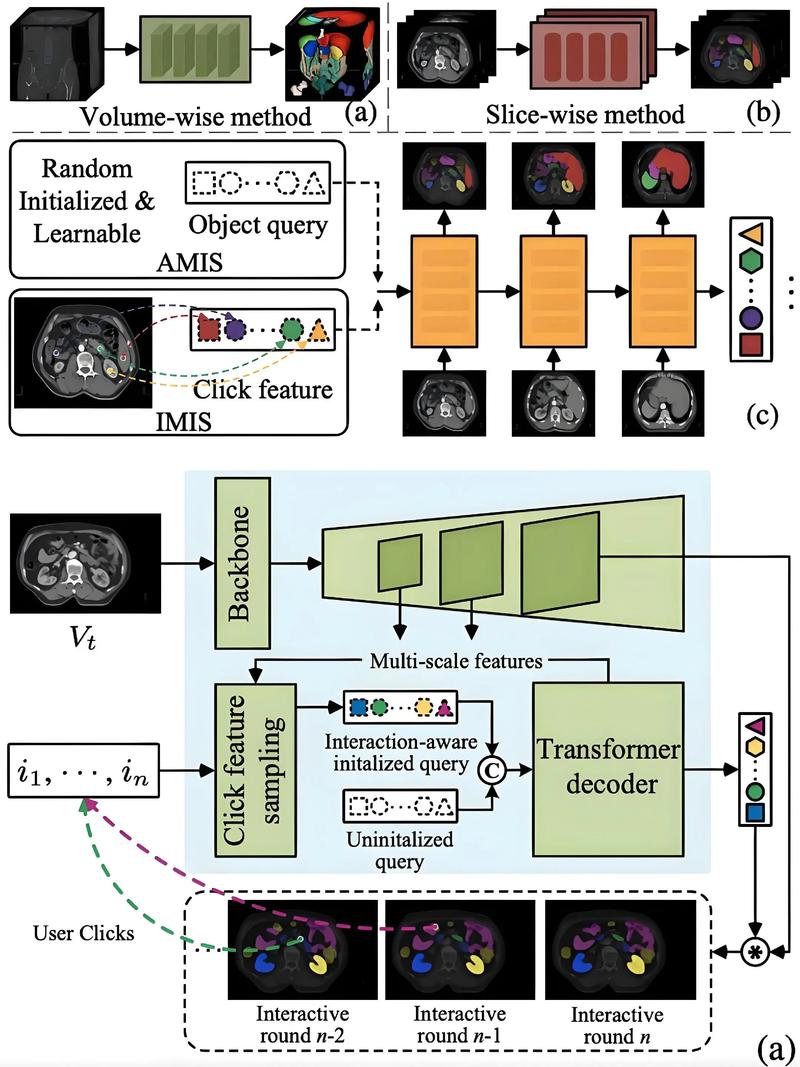

基于深度学习的跟踪

- 思想:利用深度神经网络提取目标的高维、判别性特征,并结合先进的跟踪算法来处理运动和遮挡。

- 代表算法:

- MDNet (Multi-Domain Network):开创了深度学习跟踪的先河,使用多个域共享的卷积层和特定域的分类层。

- SiamFC / SiamRPN:Siamese Network(孪生网络)架构的典范,它将目标模板和搜索区域分别输入两个共享权重的网络,提取特征后进行相关运算或区域预测,这种“模板-搜索”范式速度快、精度高,成为现代跟踪器的主流。

- SiamRPN:将RPN(来自Faster R-CNN)引入Siamese框架,同时进行分类和边界框回归,性能强大。

- SiamMask:在SiamRPN基础上加入实例分割分支,实现像素级的目标跟踪。

- DiMP / LADNet:更先进的跟踪器,通过在线更新网络权重来适应目标的外观变化,进一步提升了鲁棒性。

检测与跟踪的协同工作:Tracking-by-Detection

在大多数实际应用(如视频监控)中,我们采用的是“检测-跟踪”(Tracking-by-Detection)范式,这是一个经典的级联流程:

- 第一帧:运行一个目标检测器,找出所有感兴趣的目标,并为每个目标分配一个唯一的ID,创建跟踪列表。

- 后续帧:

- 跟踪:使用目标跟踪器(如SiamRPN)对上一帧的每个目标进行预测,得到其在当前帧的大致位置。

- 检测:在当前帧上运行目标检测器,找出所有目标。

- 数据关联:这是最关键的一步,将跟踪器预测的目标与检测器检测出的目标进行匹配,常用算法有匈牙利算法或IOU(交并比)匹配。

- 状态更新:

如果成功